Monográfico

Percepciones y eficacia de los mecanismos de detección de plagio en revistas científicas de Ciencias Sociales españolas, portuguesas e iberoamericanas

Perceptions and effectiveness of plagiarism detection mechanisms in Spanish, Portuguese and Latin American Social Sciences journals

Percepções e eficácia dos mecanismos de deteção de plágio em revistas científicas de Ciências Sociais espanholas, portuguesas e ibero-americanas

西班牙、葡萄牙及伊比利亚美洲社科期刊抄袭检测机制的感知和效率

تصورات وفعالية آليات كشف الانتحال في المجلات العلمية الإسبانية والبرتغالية والأيبيرية الأمريكية للعلوم الاجتماعية

Percepciones y eficacia de los mecanismos de detección de plagio en revistas científicas de Ciencias Sociales españolas, portuguesas e iberoamericanas

RELIEVE. Revista Electrónica de Investigación y Evaluación Educativa, vol. 29, núm. 2, 2023

Universidad de Granada

Esta obra está bajo una Licencia Creative Commons Atribución-NoComercial 4.0 Internacional.

Recepción: 26 Septiembre 2023

Aprobación: 04 Noviembre 2023

Publicación: 11 Diciembre 2023

Financiamiento

Fuente: Consellería de Cultura, Educación e Universidade (Xunta de Galicia, Galicia, España)

Nº de contrato: 18/2022.

Resumen: Detectar el plagio es un desafío clave para los comités editoriales de revistas científicas. Este estudio investiga la detección de plagio en 166 revistas de Ciencias Sociales Iberoamericanas indexadas en Scopus, mediante un cuestionario digital que generó datos para un análisis cuantitativo y cualitativo. Se encontró que, aunque la mayoría de las revistas utilizan software de detección de plagio, existen argumentos divididos sobre su eficacia. El autoplagio y el uso inadecuado de la paráfrasis son las principales razones para el rechazo de manuscritos, y mientras que la mayoría de las revistas descalifica inmediatamente los manuscritos plagiados, un 15% permite a los/las autores/as corregir y reenviar sus trabajos. El estudio concluye que las medidas preventivas actuales son insuficientes para erradicar el plagio, sugiriendo la necesidad de estrategias más efectivas para combatir esta práctica en el ámbito académico.

Palabras clave: Comité editorial, ética, integridad académica, plagio.

Abstract: One of the greatest challenges faced by the editorial boards of scientific journals is related to the detection of plagiarism in the manuscripts received. This study addresses this issue based on the perception of the members of editorial committees of 166 journals in the field of Social Sciences in the Ibero-American context indexed in Scopus. The responses were collected through a digital questionnaire, and a quantitative and qualitative analysis of the information provided was conducted. The results show that most of the journals consulted have plagiarism detection software, with numerous reasons for and against its use. Most of the articles discarded in the reception processes include self-plagiarism and covert plagiarism through paraphrasing. In cases of plagiarism, most journals reject manuscripts in the reception process, although it is noteworthy that more than 15% give authors the opportunity to correct the error and resubmit the paper. This study concludes that, despite taking preventive measures, these do not guarantee the eradication of such a problem.

Keywords: editorial boards, ethics, academic integrity, plagiarism.

Resumo: Um dos maiores desafios enfrentados pelas comissões editoriais das revistas científicas está relacionado com a deteção de plágio nos manuscritos recebidos. Este estudo aborda esta questão com base na perceção dos membros das comissões editoriais de 166 revistas da área das Ciências Sociais no contexto ibero-americano indexadas no Scopus. As respostas foram recolhidas através de um questionário digital, tendo sido realizada uma análise quantitativa e qualitativa das informações fornecidas. Os resultados constatam que a maioria das revistas consultadas dispõe de software de deteção de plágio, havendo muitas razões a favor e contra a sua utilização. A maior parte dos artigos rejeitados nos processos de receção recorre ao autoplágio e ao plágio encoberto através de paráfrases. Nos casos de plágio, a maioria das revistas rejeita os manuscritos no processo de receção, embora seja de notar que mais de 15% dão aos autores a oportunidade de corrigir o erro e voltar a submeter o artigo. De um modo geral, conclui-se com base neste estudo que, apesar de tomar medidas preventivas, estas não garantem a erradicação do problema.

Palavras-chave: Comissão editorial, ética, integridade académica, plágio.

摘要: 对收到的文稿进行抄袭检测是科学期刊编辑委员会需要面对的艰巨挑战之一。因此该研究试图对来自Scopus索引的166部伊比利亚美洲社科领域期刊的编委会成员进行感知收集,并在此基础上进行分析。我们对通过数字问卷收集到的回复信息进行定量与定性分析。结果显示研究涉及的大部分期刊都有抄袭检测软件,其中我们也发现并收集了很多赞同或反对使用该软件的理由。在收稿过程中被淘汰的大部分文章都是通过改写形式进行的抄袭或者一稿多投情况。如果被发现抄袭,大部分期刊会在收稿过程中拒稿,但是也有15%的情况是期刊会给作者改正错误重新投稿的机会。总的来说,在该研究的基础上我们发现虽然相关机构会采取预防措施,但是这并没有保证问题的彻底根除。

關鍵詞: 编辑委员会, 道德, 学术诚信, 抄袭.

ملخص: حد أكبر التحديات التي تواجهها هيئات تحرير المجلات العلمية يتعلق باكتشاف السرقة الأدبية في المخطوطات المستلمة. تتناول هذه الدراسة هذه القضية بناءً على تصور أعضاء لجان التحرير في 166 مجلة في مجال العلوم الاجتماعية في السياق الأيبيري الأمريكي المفهرس في سكوبوس. وتم جمع الإجابات من خلال استبيان رقمي, وإجراء تحليل كمي ونوعي للمعلومات المقدمة. تؤكد النتائج أن غالبية المجلات التي تمت استشارتها لديها برامج للكشف عن الانتحال, كما تقدم أيضًا أسبابًا عديدة مؤيدة ومعارضة لاستخدامها. معظم المقالات التي يتم إهمالها في عمليات الاستقبال تنطوي على سرقة أدبية ذاتية وانتحال خفي من خلال إعادة الصياغة. في حالات الانتحال, ترفض معظم المجلات المخطوطات في عملية الاستقبال, على الرغم من أنه من الجدير بالذكر أن أكثر من 15% تمنح المؤلفين الفرصة لتصحيح الخطأ وإعادة إرسال المقال. بشكل عام، نستنتج بناءً على هذه الدراسة أنه على الرغم من اتخاذ التدابير الوقائية, إلا أنها لا تضمن القضاء على المشكلة المذكورة

الكلمات المفتاحية: هيئة التحرير, الأخلاقيات, النزاهة الأكاديمية, الانتحال.

Introducción

Los resultados obtenidos en la investigación científica generan un conocimiento que es la base de otros estudios; en una suerte de construcción piramidal, la investigación (que adopta la forma de artículo científico), se convierte en un referente para otros estudios, de manera que puedan ser replicados o criticados y permitan generar avances en el conocimiento científico (Monzón-Pérez et al., 2020; Muñoz-Cantero, 2017).

Los comités editoriales de las revistas científicas juegan un papel esencial en la difusión del conocimiento científico y, al mismo tiempo, en la detección y control de posibles conductas inapropiadas, ya que una de sus principales responsabilidades es velar porque los trabajos publicados cumplan con los más altos estándares éticos y científicos, como indican el Committee on Publication Ethics (COPE), y otros organismos y asociaciones como el International Committee of Medical Journal Editors (ICMJE), la WorldAssociation of Medical Editors (WAME), la Office of Research Integrity (ORI), y el Council of Science Editors (CSE).

Una de las violaciones de la ética científica más graves y extendidas a las que suelen enfrentarse los comités y editores de revistas es el plagio en sus diferentes formas (Pastor, 2018). Sobre esta cuestión, cabe señalar que existen varios tipos de plagio, cada uno con diferentes niveles de gravedad y características que van desde la reproducción literal, sin citar, de pequeños fragmentos, con predominio de estructuras teóricas (Monzón-Pérez et al., 2020), hasta la copia de artículos completos —ejemplificada por casos de autoplagio o la duplicación explícita de una publicación (Bretag & Carapiet, 2007).

El plagio forma parte del conjunto de faltas que pueden cometerse en el proceso de publicación e incluye, entre otras, malas prácticas como la autoría ficticia, la publicación fragmentada o salami slicing, la inflación o invención de referencias, etc. (Baiget, 2010; Fernández-Cano, 2022; Zúñiga-Vargas, 2020). Centrándonos en el plagio, los autores suelen ser más propensos a reproducir su propio trabajo (autoplagio) que el de terceros (Yu-Chih, 2013), y a copiar, en mayor medida, secciones específicas de los artículos como el apartado de la metodología (Jia et al., 2014) o, como indican Bruton y Rachal (2015), tablas, figuras e imágenes.

En muchos casos, los comportamientos poco éticos de los investigadores están relacionados, como señalan Giménez-Toledo (2015) y Muñoz-Borja et al. (2016), con factores como el prestigio y la reputación de la publicación para los/as autores/as y la presión a la que se ven sometidos algunos/as investigadores/as (publish or perish) como consecuencia de la creciente cuantificación de los procesos de medición y evaluación de la calidad y el impacto de sus publicaciones (Becker & Lukka, 2022).

El plagio, en cualquier caso, es la conducta deshonesta más extendida en la publicación de resultados científicos, como muestra el metaanálisis realizado por Pupovac y Fanelli (2015), quienes concluyeron que la prevalencia de esta mala práctica es superior a la de otras como la falsificación y la fabricación de resultados. Así, nos encontramos ante una situación en la que la responsabilidad última de garantizar la calidad e integridad científica de los trabajos recibidos queda en manos de los/as revisores/as y editores/as de las revistas (Higgins et al., 2016). Para ello, los comités editoriales analizan los documentos que reciben con el fin de detectar comportamientos desviados, normalmente relacionados con el plagio, ya que la detección de otras malas prácticas como la fabricación y falsificación de datos es una tarea extremadamente complicada (White, 2005). Según Reyes (2009, p. 9), «una de las funciones más ingratas que pueden asumir los editores de publicaciones científicas es la de sospechar el plagio y, tras investigarlo, comprobar que se intentó o, peor aún, se produjo a pesar de su intención de evitarlo». Wen-Yau (2020) muestra que, para las revistas científicas, hay dos puntos principales de preocupación en el proceso de recepción y aceptación de la revisión de manuscritos: el primero se refiere a cuestiones relacionadas con el software utilizado para la detección del plagio, y el segundo a la detección de los diferentes tipos de plagio. En este sentido, hoy en día existen un buen número de programas y aplicaciones informáticas, tanto gratuitas como de pago (Turnitin, Check for Plagiarism, Urkund, etc.), que permiten detectar similitudes en el contenido textual entre un documento analizado y contenidos accesibles en la Web y en bases de datos de estos programas (Muñoz-Cantero, 2018), aunque su eficacia y potencialidad ha sido cuestionada en numerosas ocasiones (Foltýnek et al., 2020).

Sin embargo, otros/as autores/as destacan que una de las preocupaciones de los equipos editoriales no radica en el uso de sistemas de detección de plagio, sino en la existencia de una gran dispersión normativa que hace necesario el diseño de un código ético uniforme para, por ejemplo, las revistas del ámbito de las ciencias sociales (Muñoz-Borja et al., 2016).

Siguiendo esta idea, Debnath y Cariappa (2018) destacan la necesidad de establecer políticas editoriales bien definidas que tengan funciones preventivas y disuasorias. La realidad es que, dentro de sus políticas, las revistas pueden tomar acciones que van desde la retractación de artículos plagiados o la publicación de avisos en la revista, hasta la simple inacción (Debnath, 2016, Wager & Wiffen, 2011; Williams & Wager, 2013). Entre las acciones proactivas destacan las señaladas en los estudios de Solís-Sánchez et al. (2018), que proponen hacer pública la lista de científicos plagiadores. Por su parte, Schroter et al. (2018) abogan por estrategias dirigidas a establecer acciones formativas para hacer frente a la falta de conocimiento de las normas éticas entre los/as investigadores.

Por último, cabe destacar que, a la hora de tratar de estimar la magnitud del plagio en la comunicación y divulgación científica, la mayoría de las investigaciones analizan casos o incidencias posteriores a la publicación, destacando estudios sobre retractaciones o trabajos centrados en el análisis de artículos publicados mediante programas de detección de plagio, como es el caso de las aportaciones de Baskaran et al. (2019), Bretag y Carapiet (2007), Jia et al. (2014), Krokoscz (2021), Monzón-Pérez et al. (2020), Thomas (2019), Taylor (2017) y Zhang (2010). En este sentido, muy pocos estudios consideran el plagio en la prepublicación (Smart & Gaston, 2019), cuestión que aborda la presente propuesta y le otorga un valor diferencial.

El estudio que aquí se presenta pretende explorar la cuestión del plagio en los procesos de recepción de artículos en revistas de lengua española (España y América Latina) y portuguesa (Brasil y Portugal) significativas en el ámbito de las ciencias sociales y Jurídicas, desde el punto de vista de los/as editores/as y/o quienes publican dichas revistas. Así, se pretende determinar los sistemas y procedimientos de detección del plagio en los procesos de revisión de manuscritos por parte de estas revistas, analizar la incidencia de los casos de plagio en los manuscritos recibidos y las posibles líneas de actuación.

Método

Para abordar el objeto de estudio se define una estrategia de investigación centrada en el uso de enfoques de corte cualitativo y cuantitativo en lo que se conoce como tercer paradigma de investigación (Gorard & Taylor, 2004) o tercera comunidad de investigación (Teddlie & Tashkkori, 2009); se está pues, ante un enfoque de metodología mixta.

Participantes

La población de estudio está constituida por 584 revistas de España, América Latina, Brasil y Portugal indexadas en Scopus en la categoría de ciencias sociales (año de referencia 2020). La muestra (que se refleja en el número de respuestas obtenidas) está formada por un total de 166 revistas que representan el 28,4% de las 584 revistas consideradas inicialmente, de las cuales el 78,9% corresponden a revistas ubicadas en el ámbito hispanohablante (85 revistas editadas en España y 46 en países latinoamericanos de habla hispana), y el 21% en el ámbito lusófono (36 revistas editadas en Portugal y 72 en Brasil). La distribución de las revistas analizadas, según la posición que ocupan en Scopus en su categoría, es la siguiente: Q1 (15,1%), Q2 (21,1%), Q3 (33,7%) y Q4 (30,1%).

A las personas que decidieron voluntariamente participar en el estudio se les pidió que facilitaran sus identificadores personales, como nombres e información de contacto, para posibles consultas posteriores. Sin embargo, el acceso a cualquier información personal identificable se limitó exclusivamente al equipo de investigación. Todos estos datos se depuraron meticulosamente antes de la fase de análisis para garantizar la confidencialidad de las respuestas.

Procedimiento de recogida de información

Para llevar a cabo el estudio, se diseñó el cuestionario digital EVALPLA.rev utilizando la plataforma Google Forms. Para verificar la herramienta se realizó un análisis de contenido, considerando los procedimientos seguidos en estudios similares (Reyes, 2009; Solís-Sánchez et al., 2018). Asimismo, y con el objetivo de contrastar sus condiciones de uso, fue revisado por tres expertos especializados en el tema de plagio e integridad académica con amplia experiencia investigadora. Posteriormente, se diseñó una nueva versión del cuestionario que respondieron 40 directores/as y/o editores/as de revistas científicas. A partir de sus respuestas se construyó la versión final del cuestionario de 35 ítems con variables categorizadas que recogían información cualitativa y cuantitativa referida a: datos de identificación de la revista; estrategias y sistemas de detección del plagio utilizados por las revistas; tratamiento del plagio en los manuscritos recibidos por la revista; perfil del autor que plagia; posibles líneas de actuación. Se realizó una versión del cuestionario en español y otra en portugués.

La recogida de información tuvo lugar durante el primer trimestre del 2022, utilizando dos estrategias:

- el envío de un correo electrónico al email de contacto de las revistas que figuran en las páginas web de cada publicación y;

- el envío de un correo electrónico personalizado a cada responsable o editor, lo que supuso la búsqueda del correo electrónico particular de cada uno de ellos/as.

Se remitieron tres correos electrónicos con una dilación de 15 días entre cada uno, recordando la solicitud de cumplimentación del cuestionario.

Procedimiento de análisis de la información

Para analizar la información obtenida se llevó a cabo un estudio cuantitativo de corte descriptivo, calculando frecuencias, porcentajes y coeficientes de correlación, y de comparación, empleando la prueba no paramétrica de Chi Cuadrado, con el programa estadístico IBM SPSS Statistics versión 27.0. También se realizó un análisis de corte cualitativo, mediante el programa MAXQDA, aplicando técnicas interpretativas a las respuestas discursivas de los/las participantes.

Resultados

Estrategias y mecanismos de detección del plagio en la recepción de artículos

La mayoría de las revistas de la muestra disponen de mecanismos o sistemas automáticos de detección de plagio (tabla 1) en el proceso de revisión de los manuscritos recibidos (77,1%) y se constata que a mejor posición en el ranking de impacto SJR, mayor implantación de sistemas de detección de similitudes. Las revistas que no disponen de dichas herramientas (n=38, lo que supone un 22,9%), aplican otros mecanismos internos para garantizar la calidad de los manuscritos como la revisión manual por parte del consejo o comité editorial (54,3%), confiar en los/las revisores/as (21,7%), o bien que el programa de detección de plagio lo apliquen los/las revisores/as si disponen de este (8,7%).

Entre los programas más utilizados por las revistas destacan: Turnitin (33,1%) y Urkund (13,3%). Otros programas utilizados en menor medida son Crosscheck Ithenticate, Simililatity Check, etc. Hay que señalar que existen revistas, especialmente las situadas en Q1, que utilizan varios programas de detección de similitudes textuales, y también que algunas revistas optan por conjugar el uso de programas de detección de plagio con el análisis de contraste en internet mediante algún buscador (4,9%).

| Posición de la revista | Cuentan con programas de detección de plagio | No cuentan con programas de detección de plagio |

| Q1 | 17,9% | 5,2% |

| Q2 | 21,8% | 18,4% |

| Q3 | 34,3% | 31,5% |

| Q4 | 25,7% | 44,3% |

| Total | 77,1% | 22,9% |

Si centramos la atención en la existencia de un umbral de porcentaje de similitud establecido por las revistas a la hora de analizar los resultados generados por los programas de detección de plagio, se constata que un 38,2% de la muestra no lo tiene establecido y si se hace una valoración individual dependiendo de cada caso, un 18,1% de las revistas analiza todos los casos individualmente, sea cual sea el porcentage de similitud textual encontrado por el programa de detección. Un 43,7% del total de revistas que cuentan con programas de detección de plagio tienen establecidos unos umbrales a partir de los cuales deciden revisar los manuscritos en búsqueda de plagio: un 10% lo hace ante casos en los que el programa haya detectado una similitud de entre 1% y 15%; un 18,1% lo hace cuando el porcentaje se sitúa entre el 16% y el 25%, y un 15,4% lo hace ante casos de porcentajes de similitud superiores al 25%.

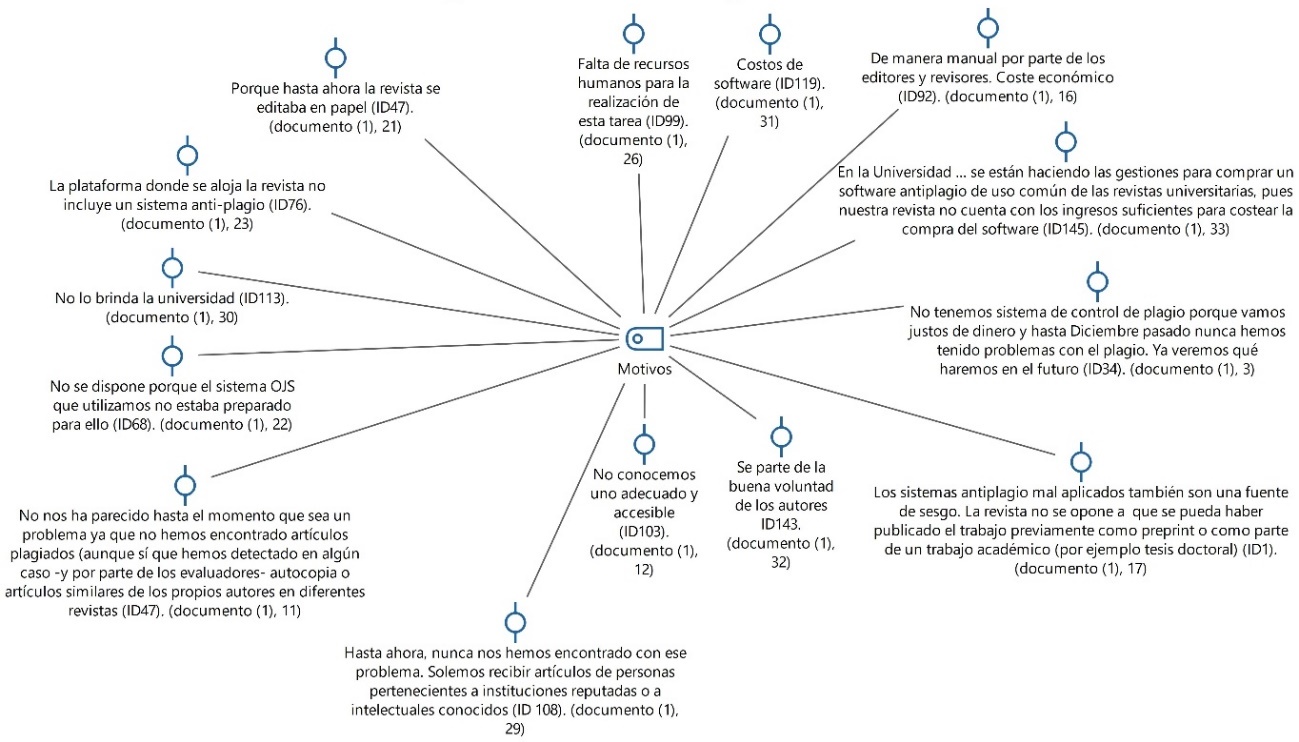

A la pregunta abierta sobre cuáles son las razones por las que 38 revistas no disponen de mecanismos de comprobación de plagio en los textos recibidos, el análisis cualitativo realizado revela que son varias (figura 1): por considerarlo innecesario (7), porque la universidad en la que está alojada la revista o la editorial de la que depende no se lo proporciona (3), porque desconocen su existencia o desconfían de los sesgos que dichos programas pueden producir (3), o bien por sus altos costes (5). No obstante, algunas revistas (5) barajan la posibilidad de emplear un programa de detección de plagio en el futuro, mientras que otras lo rechazan de plano y confían en la “buena voluntad” y en la “reputación” de los/las autores/as (2).

Figura 1.

Motivos de no utilización de los programas de detección de plagio

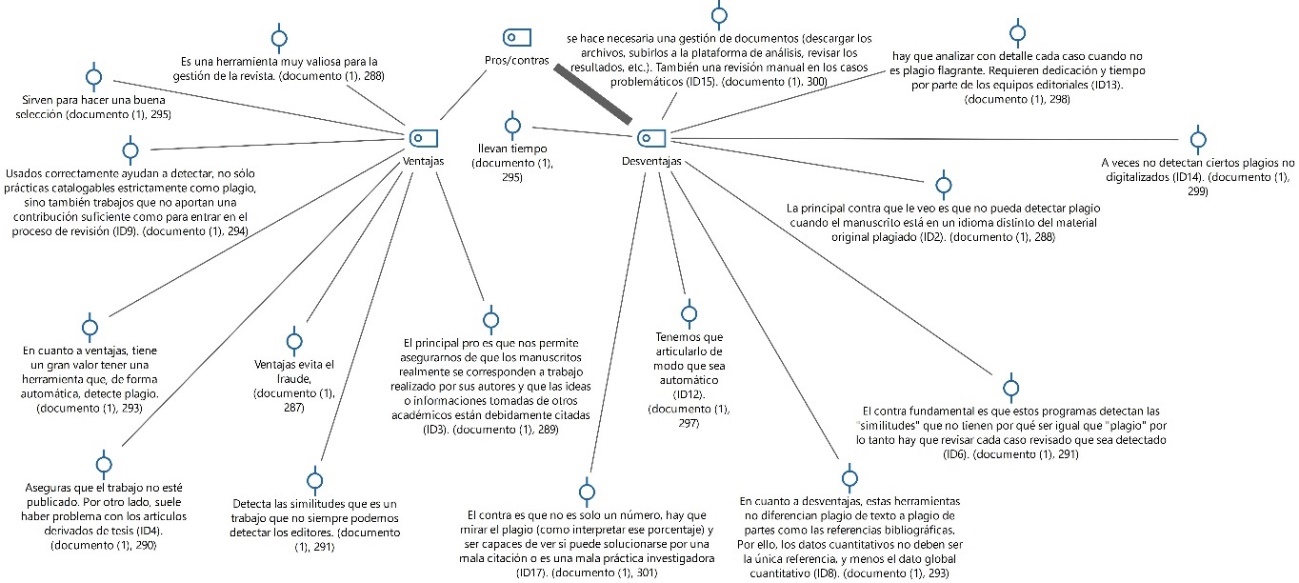

Otra de las preguntas abiertas planteadas aborda los pros y contras del empleo de los programas de detección de plagio. La figura 2 muestra que son numerosas las revistas que han resaltado los aspectos valiosos de las herramientas de detección de plagio en relación con el proceso de gestión de las mismas, sobre todo para poder realizar de forma casi automática una buena selección de los artículos que reciben en cuanto a su originalidad y empleo de las fuentes bibliográficas. Sin embargo, también han señalado numerosas desventajas de estas herramientas; las principales se centran en que el proceso no es completamente automático, de tal forma que comporta una gran inversión de tiempo para realizar posteriormente un análisis cualitativo de los informes generados por el software. A ello suman el alto coste que dichos programas acarrean y las deficiencias en cuanto a la detección de similitudes en textos traducidos de otros idiomas o textos que plagian obras en formato papel.

Figura 2.

Pros/contras del empleo de herramientas de detección de plagio en los procesos de recepción de manuscritos

Tipología y prevalencia de artículos descartados por plagio en el proceso de recepción

En primer lugar, hay que señalar que los tipos de plagio más detectados por las revistas son: el autoplagio (46,4%), el plagio encubierto mediante parafraseados (12,2%) y el textual (5,8%). Otras revistas detectan combinaciones de copia, como el autoplagio con el plagio encubierto 11,6%, el autoplagio y el plagio textual 6,4% y el autoplagio combinado con el plagio invertido o derivado de traducciones 3,2%.

En la mayoría de las revistas, el porcentaje de artículos descartados por plagio en los procesos de recepción es relativamente bajo. Así, el 79,1% de las revistas rechaza entre el 1% y el 5% de los artículos antes de que comience el proceso de revisión por pares; el 7,3% rechaza entre el 6% y el 10%; el 2,8% de las revistas rechaza entre el 11% y el 15% de los artículos por plagio; y el 1,1% rechaza más del 15% de los artículos por plagio. El 9,7% de las revistas declara no disponer de datos al respecto.

Para establecer y comparar la tasa de rechazo por plagio y el impacto de la revista, se ha generado un indicador basado en la asignación de una puntuación a cada rango de rechazo (1 punto entre el 1% y el 5%; 2 puntos entre el 6% y el 10%; 3 puntos entre el 11% y el 15%; 4 puntos por encima del 15%). El resultado del cálculo de las medias obtenidas muestra que las revistas de Q1 tienen una tasa de rechazo sustancialmente superior al resto (1,44), seguidas de las revistas de Q4 con una tasa de rechazo de 1,14 y, por último, las de Q3 y Q2 tienen una tasa de rechazo de 1,06 y 1,05, respectivamente.

Si analizamos la tasa de rechazo por plagio en los procesos de recepción por contexto geográfico, las revistas publicadas en países latinoamericanos presentan la tasa de rechazo más alta (1,41), seguidas de las españolas (1,14), las brasileñas (1,07) y, por último, las portuguesas (1).

Actuaciones llevadas a cabo ante casos de artículos con porcentajes de similitud alto

La principal medida que adoptan los consejos de redacción o de edición de las revistas participantes en el estudio cuando detectan artículos con un alto grado de similitud es comprobarlos manualmente (32,9%) y, si se detecta plagio, se rechaza el manuscrito antes de enviarlo a los/as revisores/as. En segundo lugar, casi tres de cada diez revistas (28,9%) rechazan directamente el artículo sin ni siquiera revisarlo. Un 12,8% analiza el manuscrito y, si se detecta plagio, pide a los/as autores/as que corrijan el error y vuelvan a presentar el trabajo. Por último, el 3,4% da una segunda oportunidad al artículo para que se revise y se vuelva a enviar (véase la tabla 2).

| ¿Cómo se actúa? | Porcentaje |

| Se hace una comprobación manual por parte de la revista (consulta de las fuentes originales, uso de buscadores para detectar potenciales copias, etc.) y si se comprueba la existencia de plagio se rechaza. | 32,9% |

| Se notifica a los/las autores/as y se les invita a que revisen su trabajo y lo reenvíen. | 3,4% |

| Se notifica a los/las autores/as y se rechaza el artículo. | 28,9% |

| Se hace una comprobación manual y se indica a los/las autores/as que reduzcan el porcentaje de similitud. Si no lo hacen se rechaza el artículo. | 12,8% |

| Otras posibilidades. | 4,0% |

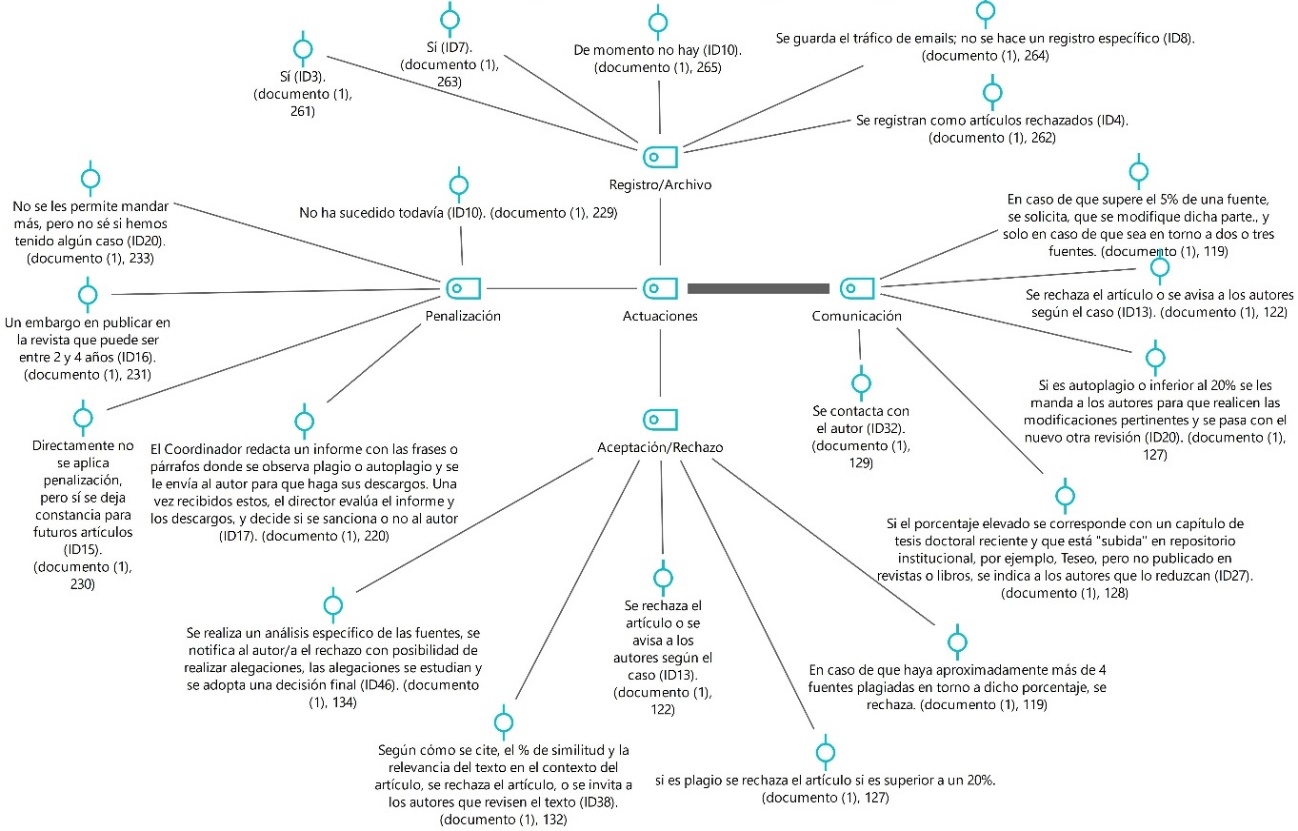

La figura 3 muestra cómo la mayoría de las revistas optan por establecer un proceso de comunicación con los/as autores/as (la anchura de la línea refleja un mayor número de respuestas). Según los casos, optan por aceptar (permitir cambios) o rechazar el artículo analizado, e incluso establecen diversos modelos de sanciones (embargos, no permitir la publicación, redacción de informes al efecto, etc.).

Figura 3.

Actuaciones ante la detección de plagio.

Potenciales estrategias y líneas de actuación ante el plagio en la recepción de manuscritos

Según la tabla 3, las estrategias mejor valoradas por los/as responsables editoriales están relacionadas con acciones dirigidas a formar tanto a los/as editores/as en procesos de detección de plagio como a los/as investigadores/as en aspectos de integridad y ética en la investigación. La estrategia peor valorada es dar a conocer los casos de plagio en la página web de la revista (media de 2,13 en una escala de 1 a 5 donde 1 significa "Totalmente en desacuerdo" y 5 "Totalmente de acuerdo"). La posibilidad de notificar a las agencias de evaluación y acreditación universitaria los casos de plagio detectados recibe una mayor aprobación, ya que esta estrategia alcanza una media de 3,22. Otras líneas de actuación con valoraciones positivas son las relacionadas con la coordinación entre revistas, el establecimiento de sistemas y procedimientos compartidos y mecanismos de detección comunes.

| Líneas de actuación | N | Media | Desviación típica |

| Registro de casos | 163 | 3,51 | 1,330 |

| Sistema de banderas | 163 | 3,26 | 1,294 |

| Notificación agencias | 162 | 3,18 | 1,355 |

| Publicitar los casos en la web de la revista | 162 | 2,13 | 1,262 |

| Unificar sistemas control | 162 | 3,76 | 1,337 |

| Procedimientos compartidos | 162 | 3,90 | 1,262 |

| Penalización reconocimiento | 99 | 3,21 | 1,136 |

| Curso formativos a editores | 97 | 4,28 | ,965 |

| Establecer un porcentaje techo de similitud común | 96 | 3,60 | 1,349 |

| Cursos formativos a investigadores/as noveles | 96 | 4,33 | ,890 |

| Cursos formativos investigadores | 96 | 4,18 | ,951 |

| Estrategias de actuación comunes | 100 | 3,79 | 1,241 |

Discusión y conclusiones

Los resultados de este trabajo nos permiten, en primer lugar, abordar la magnitud y frecuencia de los casos de plagio detectados en el proceso de recepción de artículos de revistas de alto impacto en el área de las ciencias sociales y jurídicas en el contexto iberoamericano. A pesar de ello, somos conscientes de que es muy difícil dar cifras definitivas sobre la frecuencia de casos de plagio en el envío de manuscritos, como suele ocurrir, por diversas razones, en los estudios sobre integridad académica y ética en la investigación (Comas et al., 2023). La mayoría de las revistas consultadas se sitúan en la franja baja (entre el 1% y el 5% de los artículos recibidos son rechazados por plagio), lo que invita a reflexionar sobre estos datos en relación con los resultados de un reciente metaanálisis sobre la detección de plagio en la recepción de artículos por parte de las revistas científicas (que cifra en un 18% el total de manuscritos rechazados por este motivo) (Pupovac, 2021). A la luz de esta diferencia, surgen varias preguntas, por ejemplo: ¿Existen muchos casos de plagio no detectados en las revistas participantes en el estudio? ¿Son más éticos e íntegros los/as autores/as que envían sus trabajos a revistas iberoamericanas del ámbito de las ciencias sociales y jurídicas? Estas y otras cuestiones serán analizadas en futuros estudios.

La gran mayoría de las revistas consultadas cuentan con programas de detección automática de plagio y control de la originalidad de los textos a través de software específico, algo frecuentemente recomendado por la literatura existente (Muñoz-Cantero, 2018). También se ha constatado que, entre las revistas que afirman no disponer de sistemas de detección de plagio, principalmente por motivos económicos, se establece un procedimiento manual para valorar la originalidad de los manuscritos. Sobre esta cuestión, compartimos la opinión de Baskaran et al. (2019) que defienden la conveniencia de analizar la originalidad de los textos como requisito previo a la aceptación de un artículo para su revisión.

Este estudio muestra que los tipos de plagio detectados con mayor frecuencia son el autoplagio, el plagio encubierto mediante paráfrasis y el plagio textual. Estos resultados coinciden con los encontrados en trabajos como el de Horbach y Halffman (2019), Krokoscz (2021) y Wen-Yau (2020), clasificando el autoplagio como el tipo de fraude más extendido. La gran mayoría de las revistas participantes en el estudio no establecen un umbral de similitud textual que advierta de manuscritos sospechosos de plagio; de hecho, muchas de ellas tienden a evaluar cada caso individualmente. Las revistas que fijan un nivel establecen márgenes que oscilan entre el 15% y el 30%, superiores a los encontrados en el estudio de Yu-Chih (2013), que establece una puntuación de corte del 15%. Un aspecto sobre el que se debería mejorar el conocimiento existente es el tiempo y los recursos que puede requerir realizar un primer filtrado de los artículos recibidos por parte de un equipo editorial, especialmente si se añaden tareas como la revisión y comprobación manual de los resultados de la evaluación de originalidad de los textos generados por los programas y software utilizados en cada caso. Esto genera grandes volúmenes de trabajo que resultan difíciles para las publicaciones que no disponen de los recursos y posibilidades de grandes equipos editoriales, lo que provoca algunas de las principales quejas de los/as autores/as sobre los procesos de envío y revisión de artículos científicos (Sarabipour et al., 2019).

A los autores les llama la atención el alto porcentaje de revistas que, ante altos porcentajes de contrastes de similitud textual, rechazan los manuscritos sin hacer una evaluación manual e individualizada en cada caso. Este es un peligro contra el que queremos alertar, ya que, como se ha demostrado en algunos estudios (Foltýnek et al. 2020), la fiabilidad de los programas de detección de plagio no es completa y pueden producirse falsos positivos y falsos negativos; de hecho, se producen con frecuencia. Es por ello que consideramos necesario que las revistas establezcan algún tipo de sistema de control o verificación posterior a la aplicación del software de control de originalidad en cada caso, a pesar del tiempo y recursos necesarios para llevar a cabo los procesos de filtrado en la fase de recepción de artículos por parte del equipo editorial de la revista. En esta línea, autores como Matías-Guiu y García-Ramos (2010, p. 1) señalan que «la revisión editorial y la dotación de herramientas de evaluación para los revisores son fórmulas de prevención, pero no infalibles».

En cuanto a las líneas de actuación, la peor valorada es dar a conocer los casos en la web de la revista, en consonancia con los resultados obtenidos por Solís-Sánchez et al. (2018). Parece claro que si esto se hiciera, sería un ataque contra el derecho a la protección de datos, aunque entendemos que la difusión anónima de casos podría ser una estrategia a explorar. De la misma manera que las revistas publican sus tasas de rechazo y aceptación de artículos, se podría proporcionar a autores/as y lectores/as potenciales el número de manuscritos rechazados anualmente por infringir o contravenir las normas éticas de alguna manera; esto podría actuar como una señal de advertencia para los/as futuros autores/as, dando un mensaje claro sobre la seriedad y el rigor de la revista con respecto a los temas relacionados con la integridad en la difusión del conocimiento científico. Estos datos podrían proporcionarse individualmente en las webs de las revistas y una organización de prestigio, como la COPE, podría supervisar y gestionar una base de datos abierta con todos los casos reportados por las revistas que se adhieran a esta estrategia de transparencia, para poder tener así evidencias actualizadas.

Otra estrategia valorada por los participantes es notificar a las agencias de evaluación y/o acreditación los casos detectados (Debnath, 2016), pero nuevamente esta puede ser una medida que genere conflictos éticos y legales. Por otro lado, las líneas de actuación más valoradas tienen que ver con la formación tanto de editores/as en procesos de detección de plagio como de investigadores/as, ya sean noveles o no. Establecer cursos de formación para investigadores/as junior es una posibilidad relevante, en línea con lo afirmado por numerosos autores como Domínguez-Aroca (2012) y Schroter et al. (2018), como también lo es el caso de la formación de editores/as y del profesorado en general, en forma de planes de desarrollo profesional docente (Pamies-Berenguer et al., 2022).

Limitaciones

El estudio se centra en una muestra de revistas del área iberoamericana de ciencias sociales y jurídicas indexadas en Scopus, lo que afecta a la representación muestral al no considerar otras bases de datos y reducir la potencial generalización de resultados —la ausencia de muestras de otras disciplinas y entornos relevantes para la investigación podría incidir en ellos. No obstante, entendemos que se trata de un trabajo exploratorio que sirve para evidenciar la situación en el contexto concreto objeto de análisis y cubre la falta de estudios sobre la cuestión en el área de las ciencias sociales, lo que ha sido puesto de relieve por expertos como Resnik et al. (2010) o Jordan y Hill (2012). Además, el índice de respuestas alcanzado (28% sobre el número total de revistas inicialmente consideradas), a pesar de ser un porcentaje significativo si se compara con los índices de referencia de Kittleson (1997) y Sheehan y Hoy (1997), podría mejorarse y desarrollar en un futuro una segunda ronda para captar mayor volumen de respuestas que posibiliten mayores generalizaciones de los resultados y conclusiones.

Asimismo, el uso del cuestionario presenta sesgos en estudios como el presente y otros que se han hecho aplicando la misma metodología; por ejemplo, podemos encontrar sesgos propios de la deseabilidad social y que algunas respuestas de los/as editores/as participantes estén matizadas o influenciadas por esta cuestión. Por ello abogamos e insistimos en la idea de fomentar entre las revistas la implementación de políticas de transparencia que permitan visibilizar y publicitar los casos de mala praxis cometidos por los/as autores/as al enviar sus manuscritos. Esto contribuiría a dimensionar con mayor precisión la magitud del fenómeno, respetando siempre los derechos de protección de datos personales y privacidad de los/as autores/as.

Recomendaciones

Basándose en las conclusiones del estudio, se pueden hacer las siguientes recomendaciones:

1. Mejorar la detección de plagios: dada la frecuencia de casos de plagio en el contexto iberoamericano, se sugiere que las revistas refuercen sus estrategias para detectar esta práctica. Esto podría lograrse utilizando software de detección de plagio más sofisticado y mediante rigurosos procedimientos de comprobación manual.

2. Evaluación individual: las revistas deberían considerar la posibilidad de evaluar cada caso de sospecha de plagio individualmente en lugar de confiar únicamente en el software de detección automática. Esto se debe a que el software automático a menudo puede producir falsos positivos o negativos.

3. Umbral claro de plagio: para garantizar la coherencia en la toma de decisiones, puede ser beneficioso que las revistas establezcan un umbral claro de similitud textual que desencadene una investigación de plagio. Este umbral debe estar informado por las mejores prácticas en el campo y podría ajustarse con el tiempo.

4. Medidas de transparencia: el estudio recomienda la difusión anónima de los casos de plagio como posible estrategia para disuadir de futuras conductas indebidas. Las revistas podrían publicar en sus sitios web sus tasas de rechazo de artículos por plagio, enviando así un mensaje claro sobre su compromiso con la integridad académica.

5. Colaboración con organizaciones éticas: para promover aún más la transparencia, las revistas podrían colaborar con organizaciones éticas de prestigio como COPE para gestionar una base de datos abierta de casos de plagio denunciados.

6. Formación de editores e investigadores: el estudio revela la necesidad de mejorar la formación tanto de editores/as como de investigadores/as. Podrían establecerse cursos de formación para ayudar a los/as investigadores/as noveles a comprender la importancia de la integridad académica y dotar a los/as editores/as de mejores habilidades para detectar el plagio.

7. Alertar a las agencias de evaluación y acreditación: aunque conlleva posibles conflictos éticos y legales, puede merecer la pena considerar la posibilidad de notificar a las agencias de evaluación y acreditación los casos de plagio confirmados. Esto podría ayudar a mantener la integridad de la publicación académica y desalentar comportamientos poco éticos.

En definitiva, estas recomendaciones pretender preservar la integridad de las publicaciones académicas, desalentar el plagio y garantizar la equidad en el proceso de evaluación y publicación. No obstante, quienes hemos elaborado este trabajo somos conscientes de que se trata de una cuestión compleja que requiere una atención y una investigación constantes.

Agradecimientos

Este trabajo ha contado con el apoyo de la Consellería de Cultura, Educación e Universidade (Xunta de Galicia, Galicia, España), proyecto número de referencia 18/2022.

Referencias

Baiget, T. (2010). Ética en revistas científicas. Revista de Sistemas de Información y Documentación, 4, 59-65. https://doi.org/10.54886/ibersid.v4i.3873

Baskaran, S., Agarwal, A., Panner-Selvam, M.K., Henkel, R., Durairajanayagam, D., Leisegang, K., Majzoub, A., Singh, D., & Khalafalla, K. (2019). Is there plagiarism in the most influential publications in the field of andrology? First International Journal of Andrology Andrologia, 51(10), e13405. https://doi.org/10.1111/and.13405

Becker, A., & Lukka, K. (2022). Instrumentalism and the publish-or-perish regime. Critical Perspectives on Accounting, 102436. https://doi.org/10.1016/j.cpa.2022.102436

Bretag, T., & Carapiet, S. (2007). A preliminary study to determine the extent of self-plagiarism in Australian academic research. Plagiary: Cross-Disciplinary. Studies in Plagiarism, Fabrication and Falsification, 2(5), 92-103. https://bit.ly/3kvZq02

Bruton. S.V., & Rachal, J.R. (2015). Education Journal Editors’ Perspectives on Self-Plagiarism. Journal of Academic Ethics, 13, 13-25. https://doi.org/10.1007/s10805-014-9224-0

Comas, R., Lancaster, T., Curiel, E., & Touza, C. (2023). Automatic paraphrasing tools: an unexpected consequence of addressing student plagiarism and the impact of COVID in distance education settings. Práxis Educativa, 18, 1–19. https://doi.org/10.5212/PraxEduc.v.18.21679.020

Debnath, J. (2016). Plagiarism: A silent epidemic in scientific writing - reasons, recognition and remedies. Medical Journal Armed Forces India, 72(2), 164-167. https://doi.org/10.1016/j.mjafi.2016.03.010

Debnath, J., & Cariappa, M.P. (2018). Wishing away plagiarism in scientific publications! Will it work? A situational analysis of plagiarism policy of journals in PubMed. Medical Journal Armed Forces India, 74(2), 143-147. https://doi.org/10.1016/j.mjafi.2017.09.003

Domínguez-Aroca, M.I. (2012). Lucha contra el plagio desde las bibliotecas universitarias. El Profesional de la Información, 21(5), 498-503. https://doi.org/10.3145/epi.2012.sep.08

Fernández-Cano, A. (2022). Parasitismo académico. Torres editores.

Foltýnek, T., Dlabolová, D., Anohina-Naumeca, A., Razı, S., Kravjar, J., Kamzola, L., ... & Weber-Wulff, D. (2020). Testing of support tools for plagiarism detection. International Journal of Educational Technology in Higher Education, 17, 1-31. https://doi.org/10.1186/s41239-020-00192-4

Giménez-Toledo, E. (2015). La evaluación de la producción científica: breve análisis crítico. Revista Electrónica de Investigación y Evaluación Educativa (RELIEVE), 21(1), 1-9. https://doi.org/10.7203/relieve.21.1.5160

Gorard, S., & Taylor, C. (2004). Combining methods in educational and social research. Open University Press.

Higgins, J.R., Lin, F.C., & Evans, J.P. (2016). Plagiarism in submitted manuscripts: incidence, characteristics and optimization of screening-case study in a major specialty medical journal. Research Integrity and Peer Review, 1. https://doi.org/10.1186/s41073-016-0021-8

Horbach, S. S., & Halffman, W. W. (2019). The extent and causes of academic text recycling or ‘self-plagiarism’. Research policy, 48(2), 492-502. https://doi.org/10.1016/j.respol.2017.09.004

Jia, X., Tan, X., & Zhang, Y. (2014). Replication of the methods section in biosciences papers: is it plagiarism? Scientometrics, 98, 337–345. https://doi.org/10.1007/s11192-013-1033-5

Jordan, S. R., & Hill, K. Q. (2012). Ethical assurance statements in political science journals. Journal of Academic Ethics, 10, 243-250. http://dx.doi.org/10.1007/s10805-012-9163-6

Kittleson, M. (1997). Determining effective follow-up of e-mail surveys”. American Journal of Health Behavior. 21(3), 193-196.

Krokoscz, M. (2021). Plagiarism in articles published in journals indexed in the Scientific Periodicals Electronic Library (SPELL): a comparative analysis between 2013 and 2018. International Journal for Educational Integrity 17, art. 1. https://doi.org/10.1007/s40979-020-00063-5

Matías-Guiu, J., & García-Ramos, M. (2010). Fraude y conductas inapropiadas en las publicaciones científicas. Neurología. Publicación Oficial de la Sociedad Española de Neurología, 25(1), 1-4. https://doi.org/10.1016/S0213-4853(10)70015-3

Monzón-Pérez M.E., Oviedo-Herrera L.C., Sánchez-Ferrán, T., Valdés-Balbín, R., Camayd-Viera I., & Calero-Ricardo, J.L. (2020). Plagio en artículos de investigación en revistas biomédicas cubanas. 2016. Revista Habanera de Ciencias Médicas, 19(4), e3526. https://bit.ly/3QY73YY

Muñoz-Borja, P., Hernández-Ruíz, P., & Escobar-Sarria, J. (2016). La política editorial antifraude de las revistas científicas españolas e iberoamericanas del JCR en Ciencias Sociales. Comunicar, 48(24), 19-27. https://doi.org/10.3916/C48-2016-02

Muñoz-Cantero, J.M. (2017). Competencias transversales en la investigación. Ser y estar en la red. Aula Magna 2.0. [Blog]: https://cuedespyd.hypotheses.org/2977

Muñoz-Cantero, J.M. (2018). ¿Plagio o coincidencia? Principal causa de rechazo de los artículos científicos. Aula Magna 2.0. [Blog]: https://cuedespyd.hypotheses.org/3374

Pamies-Berenguer, M., Cascales-Martínez, A., & Gomariz-Vicente, M. A. (2022). Factores condicionantes de la transferencia de la formación y la probabilidad de transferencia. RELIEVE, 28(2), art. 7. http://doi.org/10.30827/relieve.v28i2.24604

Pastor, J. (2018). Plagiarism in publications. Archivos de la Sociedad Española de Oftalmología, 93(12), 571. https://doi.org/10.1016/j.oftal.2018.10.024

Pupovac, V. (2021). The frequency of plagiarism identified by text-matching software in scientific articles: a systematic review and meta-analysis. Scientometrics, 126(11), 8981-9003. https://doi.org/10.1007/s11192-021-04140-5

Pupovac, V., & Fanelli, D. (2015). Scientists admitting to plagiarism: a meta-analysis of surveys. Science and engineering ethics, 21, 1331-1352. https://doi.org/10.1007/s11948-014-9600-6

Resnik, D. B., Patrone, D., & Peddada, S. (2010). Research misconduct policies of social science journals and impact factor. Accountabilityin research, 17(2), 79-84. http://dx.doi.org/10.1080/08989621003641181

Reyes, H. (2009). El plagio en publicaciones científicas. Revista Médica de Chile, 137, 7-9. https://doi.org/10.4067/S0034-98872009000100001

Sarabipour, S., Debat, H. J., Emmott, E., Burgess, S. J., Schwessinger, B., & Hensel, Z. (2019). On the value of preprints: An early career researcher perspective. PLoS biology, 17(2), e3000151. https://doi.org/10.1371/journal.pbio.3000151

Schroter, S., Roberts, J., Loder, E., Penzien, D.B., Mahadeo, S., & Houle,T.T. (2018). Biomedical authors' awareness of publication ethics: an international survey. British Medical Journal Open, 8(11), e021282. https://doi.org/10.1136/bmjopen-2017-021282

Sheehan, K. B., & Hoy, N. G. (1997). Using e-mail to survey Internet users in the United States: Methodology and assessment. Journal of Computer-Mediated Communication, 4(3), https://doi.org/10.1111/j.1083-6101.1999.tb00101.x

Smart, P., & Gaston, T. (2019). How prevalent are plagiarized submissions? Global survey of editors. Learned Publishing, 32(1), 47-56. https://doi.org/10.1002/leap.1218

Solís-Sánchez, G., Cano-Garcinuño, A., Anton-Gamero, M., Alsina-Manrique de Lara, L., & Rey-Galán, C. (2018). Plagio y ética en las publicaciones científicas. Anales de Pediatría, 90(1). https://doi.org/10.1016/j.anpedi.2018.10.008

Taylor, D.B. (2017). Plagiarism in manuscripts submitted to the AJR: development of an optimal screening algorithm and management pathways. American Journal of Roentgenology, 209(1). https://doi.org/10.2214/AJR.16.17208

Teddlie, C., & Tashkkori, A. (2009). Foundations of Mixed Methods Research. Integrating Quantitative and Qualitative Approaches in the Social and Behavioral Sciences. Sage.

Thomas, A. (2019). Plagiarism in South African management journals: a follow-up study. South African Journal of Science, 115(5/6), 1-8. https://doi.org/10.17159/sajs.2019/5723

Wager, E., & Wiffen, P.J. (2011). Ethical issues in preparing and publishing systematic reviews. Journal of Evidence Based Medicine, 4(2), 130-134. https://doi.org/10.1111/j.1756-5391.2011.01122.x

Wen‑Yau, C.L. (2020). Self‑plagiarism in academic journal articles: from the perspectives of international editors‑in‑chief in editorial and COPE case. Scientometrics,123, 299-319. https://doi.org/10.1007/s11192-020-03373-0

Williams, P., & Wager, E. (2013). Exploring why and how journal editors retract articles: findings from a qualitative study. Science and Engineering Ethics, 19(1), 1-11. https://doi.org/10.1007/s11948-011-9292-0

White, C. (2005). Suspected research fraud: difficulties of getting at the truth. BMJ, 331(7511), 281-288. https://doi.org/10.1136/bmj.331.7511.281

Yu-Chih, S. (2013). Do journal authors plagiarize? Using plagiarism detection software to uncover matching text across disciplines. Journal of English for Academic Purposes, 12, 264-272. https://doi.org/10.1016/j.jeap.2013.07.002

Zhang H.Y. (2010). CrossCheck: an effective tool for detecting plagiarism. LearnedPublishing, 23, 9-14. https://doi.org/10.1087/20100103

Zúñiga-Vargas, J.P. (2020). Comportamiento ético en la publicación científica: malas conductas y acciones para evitarlas. Revista Educación, 44(1), 1-10. https://doi.org/10.15517/revedu.v44i1.35548

Notas de autor

Las líneas de investigación principales en las que trabaja son honestidad e integridad académica y atención a la diversidad y educación inclusiva, de las que han derivado proyectos de investigación, tesis de doctorado y publicaciones en revistas científicas de impacto.

jesus.miguel.munoz@udc.es

Enlace alternativo

https://revistaseug.ugr.es/index.php/RELIEVE/article/view/29097 (html)