Artículos

Validez de Constructo de la Escala de Detección de Alumnado con Altas Capacidades para Profesores de Educación Infantil, Gifted Rating Scales (GRS2-P), en una muestra española

Construct Validity of the Gifted Rating Scales (GRS 2-P) Preschool/Kindergarden Teachers Form in a Spanish sample

Validade de Constructo da Escala de Deteção de Estudantes com Elevadas Capacidades para Professores de Ensino Infantil, Gifted Rating Scales (GRS2-P), numa amostra espanhola

帮助幼儿教师识别资优学生的资优评定量表(GRS2-P)在西班牙样本上的建构效度

بناء صلاحية مقياس اكتشاف الطلاب ذوي القدرات العالية لمعلمي التعليم في مرحلة الطفولة المبكرة, Gifted Rating Scales (GRS2-P), في عينة إسبانية

Validez de Constructo de la Escala de Detección de Alumnado con Altas Capacidades para Profesores de Educación Infantil, Gifted Rating Scales (GRS2-P), en una muestra española

RELIEVE. Revista Electrónica de Investigación y Evaluación Educativa, vol. 29, núm. 2, 2023

Universidad de Granada

Esta obra está bajo una Licencia Creative Commons Atribución-NoComercial 4.0 Internacional.

Recepción: 04 Abril 2023

Aprobación: 15 Septiembre 2023

Publicación: 11 Diciembre 2023

Financiamiento

Fuente: Vicerrectorado de Investigación de la Universidad Internacional de La Rioja.

Resumen: La detección del alumnado con altas capacidades debe ser una prioridad en cualquier sistema educativo. En nuestro país el déficit de la identificación es notorio, en parte por la ausencia de instrumentos adecuados. La participación de los profesores es un elemento clave en este proceso. Este trabajo ofrece la primera validación de la Escala de Detección de alumnado con Altas Capacidades para Profesores de Educación Infantil, Gifted Rating Scales (GRS 2-P). Sobre una muestra de 134 profesores se ha llevado a cabo un análisis factorial confirmatorio (CFA) para variables ordinales y estimación (ULSMV). Se han probado seis modelos, de los cuales se ha optado por el de cinco factores que corresponde al original de la escala, que ha mostrado unos valores de ajuste adecuados ( 2/gl, 1.44; CFI .92; TLI, .93; RMSEA, .057). Por su parte, la Average Variance Explained (AVE) ha tomado valores entre .45 - .74. La fiabilidad compuesta muestra valores entre .89 a .96. Aunque existen otros modelos plausibles, hemos optado por esta solución ajustada al original (M1), si bien se sugiere realizar nuevos estudios para confirmar este extremo. La importancia de disponer de instrumentos con una validación adecuada se considera esencial en los procesos de detección que deben incorporar fuentes diversas de información, como la que aportan los profesores.

Palabras clave: Escala de detección, Altas capacidades, Identificación, Validez de constructo, Análisis factorial confirmatorio.

Abstract: The identification of students with high abilities must be a priority in any education system. In our country, the identification deficit is notorious, partly due to the absence of adequate instruments. The participation of teachers is a key element in this process. This work offers the first construct validation process of the Gifted Rating Scales (GRS 2-P) for Early Childhood Teachers for the identification of gifted in Spain. A confirmatory factor analysis (CFA) for ordinal variables and estimation (ULSMV) has been carried out on a sample of 134 teachers. Six models have been tested, of which the five-factor model corresponding to the original of the scale has been chosen, which has shown adequate adjustment values ( 2/gl, 1.44; CFI .92; TLI, .93; RMSEA, .057). For its part, the Average Variance Explained (AVE) has taken values between .45 - .74. Composite reliability shows values between .89 to .96. Although there are other empirically plausible models, we have opted for this solution adjusted to the original (M1), although further studies are suggested to confirm this point. The importance of having adequately validated instruments is considered essential in gifted identification processes that must incorporate various sources of information, such as that provided by teachers.

Keywords: Gifted Rating Scales, High Ability, Gifted Identification, Construct Validity, Confirmatory Factor Analysis.

Resumo: A deteção dos estudantes com elevadas capacidades deve ser uma prioridade em qualquer sistema educativo. No nosso país, o défice da identificação é notório, em parte devido à ausência de instrumentos adequados. A participação dos professores é um elemento-chave neste processo. Este trabalho oferece a primeira validação da Escala de Deteção de Estudantes com Elevadas Capacidades para Professores de Ensino Infantil, Gifted Rating Scales (GRS2-P). Foi realizada uma análise fatorial confirmatória (CFA) para variáveis ordinais e estimativa (ULSMV) a partir de uma amostra de 134 professores. Foram testados seis modelos, dos quais foi escolhido o modelo de cinco fatores correspondente ao original da escala, que mostrou valores de ajuste adequados ( 2/gl, 1,44; CFI, .92; TLI, .93; RMSEA, .057). Por seu lado, a Average Variance Explained (AVE) obteve valores entre .45 - .74. A fiabilidade composta apresenta valores entre .89 a .96. Apesar de existirem outros modelos plausíveis, optámos por esta solução ajustada à original (M1), embora se sugira a realização de novos estudos para confirmar. A importância de dispor de instrumentos com uma validação adequada é considerada essencial nos processos de deteção que devem incorporar diversas fontes de informação, como a fornecida pelos professores.

Palavras-chave: Escala de deteção, capacidades elevadas, identificação, validade de constructo, análise fatorial confirmatória.

摘要: 在所有的教育系统中,资优学生的识别都应该占有重要的地位。然而我们国家在这方面的不足却非常明显,其中一方面的原因就是缺乏有效的工具,而另一方面,教师的参与也是保证该过程正常进行不可或缺的因素。因此该研究对帮助幼儿教师发现资优学生的资优评定量表(GRS2-P)进行首次验证。在134名教师样本上我们对定序数据和估计(ULSMV)进行验证性因子分析(CFA)。在对六个模型进行实验后,选择了拥有与原量表对应的五个因素的模型,原因在于这个模型拥有优秀的拟合优度( 2/gl为1.44、 CFI为0 .92、TLI为0.93、 RMSEA为0.057),而且其中模型的平均提取方差值在0.45到0.74之间,组合信度值介于0.89到0.96间。我们深知存在其他的优秀模型,最终我们决定选择这个与原模型(M1)拟合的解决方案,但是我们仍建议进行更多的研究来证实这一点。我们还认为在识别过程中应该引入更多样的信息源,比如教师方面可提供的信息等等,除此以外,不可忽略的重要环节便是使用经过有效验证的工具来进行识别。

關鍵詞: 识别量表, 优质能力, 辨识, 建构效度, 验证性因子分析.

ملخص: إن اكتشاف الطلاب ذوي القدرات العالية يجب أن يكون أولوية في أي نظام تعليمي. إن العجز في تحديد الهوية أمر سيء السمعة في بلدنا، ويرجع ذلك جزئيًا إلى عدم وجود الأدوات المناسبة. تعد مشاركة المعلمين عنصرًا أساسيًا في هذه العملية. يقدم هذا العمل التحقق الأول من مقياس الكشف للطلاب ذوي القدرات العالية لمعلمي التعليم في مرحلة الطفولة المبكرة, ومقاييس تقييم الموهوبين (GRS2-P). تم إجراء التحليل العاملي التوكيدي (CFA) للمتغيرات الترتيبية والتقدير (ULSMV) على عينة مكونة من 134 معلمًا. تم اختبار ستة نماذج, تم اختيار النموذج الخماسي العامل منها, والذي يتوافق مع أصل المقياس, والذي أظهر قيم ملائمة مناسبة ( 2/df, 1.44; CFI .92; TLI, .93; RMSEA، .057). من جانبه، أخذ متوسط التباين الموضح (AVE) قيمًا تتراوح بين .45 - .74. تُظهر الموثوقية المركبة قيمًا تتراوح بين .89 إلى .96. وعلى الرغم من وجود نماذج أخرى معقولة, فقد اخترنا هذا الحل المعدل إلى الحل الأصلي (M1), على الرغم من أنه يقترح إجراء دراسات جديدة لتأكيد ذلك. تعتبر أهمية وجود الأدوات ذات التحقق المناسب أمرًا ضروريًا في عمليات الكشف التي يجب أن تتضمن مصادر متنوعة للمعلومات، مثل تلك التي يقدمها المعلمون

الكلمات المفتاحية: مقياس الكشف, القدرات العالية, التحديد, صدق البناء, التحليل العاملي التوكيدي.

Introducción

Detectar el potencial de nuestros escolares se hace manifiestamente relevante cuando tenemos en cuenta el número de alumnos de alta capacidad que actualmente en España no están identificados, alrededor del 95% (Tourón, 2023). Sabemos que el potencial no se desarrolla de manera espontánea, sino que necesita de un conjunto de catalizadores y un contexto adecuado para que se transforme en talento.

La detección temprana es apoyada de manera universal en el contexto de las necesidades educativas especiales o los trastornos del neurodesarrollo (Pfeiffer y Reddy, 1998, McLean, 2016) y cada vez más, se está reconociendo los beneficios de este enfoque en el grupo de los alumnos que muestran alto potencial o alguna habilidad sobresaliente en edades tempranas (Jackson, 2003; Morelock y Feldman, 1992; Pfeiffer, 2002; Pfeiffer y Petscher, 2008).

Esto es algo bien conocido desde hace muchas décadas, como evidencian algunos escritos originales de Leta Hollingworth (1942) y su trabajo con alumnos sobresalientes, donde ya señalaba que cuanto antes fueran identificados los alumnos dotados, más favorable sería su desarrollo. En sus estudios con personas extraordinariamente capaces (CI superior a 180) indicaba que la mayoría de los casos habían manifestado capacidad superior y desarrollo precoz antes de la Educación Primaria (Pressey, 1955) y algunos autores como Bloom, encontraron que los adultos eminentes generalmente habían sido identificados de manera temprana en sus vidas, en general en los años preescolares y habían tenido oportunidades excelentes para desarrollar su talento (Bloom 1982; 1985).

Realizar una identificación temprana en el caso de los alumnos con alta capacidad es crucial ya que, tal y como señalan Pfeiffer y Petscher (2008): “aumenta la probabilidad de futuros logros extraordinarios y reduce el riesgo de problemas sociales, conductuales, emocionales o educativos posteriores (Harrison, 2004; Hodge y Kemp, 2000; Morelock y Feldman, 1992; Pfeiffer y Stocking, 2000; Sankar-Deleeuw, 2002)” (p.19).

Sin embargo, existen todavía muchas resistencias para que esto sea una realidad asumida y se tomen las medidas educativas oportunas con diligencia. Nos encontramos bastantes dificultades para llevar a cabo este objetivo como pueden ser las presupuestarias, la escasez de programas de respuesta en edades tempranas o, sobre todo, la falta de instrumentos adecuados para realizar esta primera detección. Además, pocos maestros de Educación Infantil (aunque esto no es exclusivo de esta etapa) están capacitados o formados para detectar indicadores de alto potencial en el aula, y no disponen de instrumentos de evaluación válidos para poder llevar a cabo esta tarea. Aparte de las pruebas psicométricas de evaluación de la capacidad intelectual o del rendimiento, es necesario disponer de otras herramientas que permitan a los docentes, agentes relevantes en la detección y desarrollo del potencial de sus alumnos, observar conductas precoces o de alta capacidad potencial y poder así completar la información sobre el perfil del alumno.

Las escalas de detección disponibles para docentes son escasas y presentan algunas deficiencias técnicas que limitan su utilidad (Jarosewich et al., 2002). Para intentar paliar esta falta, después de un exhaustivo trabajo en 2003 se desarrollan las Gifted Rating Scales (GRS), unas escalas de detección para profesores, fáciles de usar, fiables y válidas que se han utilizado miles de veces y validado en varios países. Las GRS originales incluían dos formas para profesores: la GRS-P diseñada para alumnos de Educación Infantil y la GRS-S para alumnos con edades entre 6 y 13 años. Más tarde se revisan y amplían con algunas modificaciones (Shaughnessy, 2022) para dar lugar a las GRS2. El desarrollo de esta nueva edición de las escalas se lleva a cabo durante más de cuatro años y actualmente están a punto de estar disponibles baremadas para su uso en EEUU.

El objetivo central de este trabajo es estudiar la estructura de la escala en su versión para profesores de Educación Infantil (Gifted Rating Scales. Preschool/Kindergarten Form. GRS 2-P) y aportar evidencias sobre las propiedades psicométricas de la misma, en particular el estudio de la fiabilidad de cada una de sus dimensiones y su ajuste al modelo de desarrollo de la escala, es decir, estudiar su validez de constructo, con particular atención al uso de los procedimientos más adecuados a la métrica ordinal de las variables (ítems). Esta es la primera validación que se realiza en el mundo de esta nueva versión, sobre la que se ha llevado a cabo una gran cantidad de investigación en inglés (Pfeiffer y Jarosewich, 2003), particularmente en su versión anterior.

Método

Se utilizó un enfoque metodológico que se sitúa en el contexto de la validación de instrumentos de medida. Se estudió la validez de la estructura de dimensiones que definen el constructo a partir del análisis de las relaciones que se producen entre los ítems que lo componen, la denominada validez de constructo. Se emplearon técnicas factoriales confirmatorias para probar empíricamente diferentes modelos de organización de los ítems en dimensiones latentes, tal como se detalla más adelante.

Muestra

El proceso de obtención de la muestra, que se describe en el apartado de procedimiento, condujo a un total de 134 respuestas de profesores, referidas a alumnado con una edad media de 4.7 años (D.T. 0.91) que varía entre 3 y 6 años. El 55.2% de esos casos cursaban tercero de Educación Infantil (74 casos), un 30.6% segundo y el 14.2% restante cursaba primero. Gaskin y Happell (2014) recomiendan que, con 8 o más ítems por factor, si se obtienen pesos factoriales alrededor de .5, un tamaño de aproximadamente 130 casos puede ser suficiente.

La mayor parte de la información la aportaron los tutores del curso, un total de 98 respuestas (73.1%). Los profesores de materia o equivalente 15 (11.2%), los orientadores aportaron 14 (10.4%), los profesores de apoyo 4 (3%) y, finalmente, con 3 respuestas los especialistas en altas capacidades.

Respecto al grado de conocimiento de los niños que tienen esas fuentes, la mayoría (68.7%) declaran que los conocen desde hace más de un año y solo un 9% (12 casos) indica que han sido profesores por un periodo de 3 meses o menos. En la siguiente tabla se muestra la distribución completa.

| N | % | |

| De 1 a 3 meses | 12 | 9.0 |

| De 4 a 6 meses | 10 | 7.5 |

| De 7 a 12 meses | 20 | 14.9 |

| Más de un año | 92 | 68.7 |

La mayor parte (97.8%) señala que conocen bastante o muy bien a los niños. Y en solo tres ocasiones los encuestados han indicado que no los conocen muy bien. También indicaron que 21 de los casos tienen diagnóstico de altas capacidades, el 15.7%. Y, siete de los casos (5.2%) señalaron desconocimiento en esta cuestión.

Instrumento

Las Escalas GRS 2 (Gifted Rating Scales - 2th Edition), son una revisión de las Escalas GRS originales desarrolladas en 2003 (Pfeiffer y Jarosewich, 2003) que integra los mismos elementos claves que su predecesora, pero con algunas variantes y novedades, como una forma para padres, inédita, de la que hemos realizado también una primera validación en España (Tourón, et al., 2023a).

Estas son unas escalas de detección diseñadas para valorar características de los alumnos que pueden presentar altas capacidades. Dispone de dos formas para los profesores que abarcan de los 4 a los 18 años y permiten a los docentes aportar información de los alumnos en varias dimensiones.

El instrumento que aquí se analiza es la Preschool/Kindergarten Form (GRS 2–P) que está desarrollada para niños en edades comprendidas entre los 4 y 6 años y diseñada para que sea fácil de usar por los docentes en la etapa Infantil. Incluye 50 ítems organizados en 5 dimensiones. Cada ítem se valora con una escala tipo Likert de nueve puntos, dividida en tres rangos: 1 a 3 por debajo del promedio; 4 a 6 en el promedio y 7 a 9 por encima del promedio. Este formato le permite al maestro determinar primero si, en comparación con otros estudiantes de la misma edad, el alumno está por debajo del promedio, en el promedio o por encima del mismo en un comportamiento específico. Luego, el profesor determina, dentro del rango, si el estudiante está en la parte inferior, media o superior.

La siguiente es una breve descripción de las cinco dimensiones incluidas en la GRS 2-P:

Capacidad Intelectual: Valora el razonamiento abstracto (Sternberg, 1985), la resolución de problemas (Sternberg, 2000a), el razonamiento, la velocidad mental (Gagné, 1993) y la memoria (Dai, 2018; Pfeiffer, 2015; Silverman, 2018; Sternberg y Kaufman, 2018).

Aptitud Académica: referida a la habilidad del alumno para manejar material basado en hechos o relacionado con la escuela. Unos altos niveles de competencia en lectura, matemáticas y otros aspectos del currículo escolar son indicativos de capacidad académica, así como la facilidad para adquirir nuevos conocimientos y habilidades (Gagné, 1993) y la capacidad para comprender material complejo. Los estudiantes académicamente dotados, a menudo, poseen una gran cantidad de información (Schneider, 2000; Sternberg, 2000a), incluido un amplio conocimiento del mundo que los rodea (Olszewski-Kubilius et al., 2019; Pfeiffer, 2015).

Creatividad: se refiere a la capacidad del alumno para pensar, actuar o producir pensamientos o productos únicos, originales, novedosos o innovadores (Abdulla y Cramond, 2017; Cropley, 2000;Csikszentmihalyi y Wolfe, 2000; Runco, 2014). La creatividad se puede expresar de varias maneras: resolviendo problemas, experimentando con nuevas ideas, formulando una solución para un proyecto grupal, o usando la imaginación. Los estudiantes creativos son inventivos (Cropley y Urban, 2000), curiosos (Beghetto y Plucker, 2016) e inquisitivos (Presbury et al., 1997). Muestran una preferencia por el desafío y la complejidad (Olszewski-Kubilius, 2000) y se involucran en la resolución de problemas de manera perspicaz y creativa (Plucker et al., 2018; Simonton, 2000; Sternberg, 2000b; Runco, 2014).

Talento Artístico: se valora el potencial del estudiante, o la evidencia del mismo, para el teatro, la música, la danza, el dibujo o la pintura, la escultura, el canto, tocar un instrumento musical o la actuación. Se puede expresar de diferentes maneras: cómo aborda las actividades, completa las tareas o utiliza materiales de arte o medios artísticos. Los estudiantes dotados artísticamente aprenden rápidamente y exhiben habilidades más maduras y técnicamente más sofisticadas que los estudiantes no dotados (Hargreaves et al., 1996; Kozbelt, 2019; Subotnik et al., 2019; Winner y Martino, 2000). Los alumnos dotados en las artes se expresan de una manera personalizada en su trabajo o desempeño (Haroutounian, 1995, 2003; Porath, 1993).

Motivación: se refiere al impulso o la persistencia del alumno, el deseo de tener éxito, la tendencia a disfrutar de tareas desafiantes y la capacidad de trabajar bien sin estímulo ni refuerzo externos (Dweck, 1999, 2006; Ryan y Deci, 2000). La motivación no se ve como un tipo de talento; más bien, es la energía que impulsa a un estudiante a lograr un objetivo o a rendir. Las puntuaciones en esta dimensión reflejan el nivel de “coraje” (“grit”) de un estudiante (Duckworth, 2016; Duckworth y Seligman, 2005). Se puede observar cuando se trabaja en tareas académicas, proyectos artísticos o se dirige una actividad grupal (Clinkenbeard, 2012; Olszweski-Kubilius et al., 2015). No es un índice de alta capacidad, sino una medida del nivel de impulso, persistencia y deseo de triunfar del alumno. La motivación impulsa al estudiante a lograr o alcanzar un nivel ejemplar (Pink, 2009).

La escala está diseñada considerando un modelo teórico con estos cinco factores latentes, cada uno compuesto por 10 ítems, distribuidos como se muestra en la tabla 2:

| Intelectual | Académica | Creatividad | Artística | Motivación |

| I2 | I1 | I6 | I3 | I8 |

| I4 | I7 | I12 | I17 | I9 |

| I5 | I10 | I21 | I19 | I11 |

| I13 | I18 | I23 | I28 | I16 |

| I14 | I22 | I36 | I33 | I20 |

| I15 | I25 | I37 | I34 | I24 |

| I27 | I30 | I40 | I38 | I26 |

| I29 | I31 | I44 | I41 | I35 |

| I32 | I39 | I47 | I42 | I48 |

| I45 | I43 | I49 | I46 | I50 |

Procedimiento

Las escalas, originalmente en inglés, fueron traducidas independientemente por el primer y tercer autor, expertos en el ámbito de las altas capacidades. Dichas traducciones fueron comparadas entre sí sin que se observasen discrepancias. Posteriormente, la traducción fue revisada por personal técnico de la editorial a la que pertenecen actualmente los derechos de las mismas (MHS Assessment). La propuesta de los autores fue aceptada sin cambios.

Una vez se tuvo la escala en castellano se alojó en un servicio en línea (Survey Monkey) para poder hacerla accesible a los que habían de responderla. Los ítems de la escala se dispusieron aleatoriamente para evitar posibles sesgos debidos al orden original de las escalas cuando los ítems se presentan agrupados por dimensiones (Bishop, 2011; Tourón et al., 2018).

Junto con las instrucciones previas sobre como completar la escala y el objeto de la misma, se incluyeron en el formulario otras variables descriptivas como: quién contesta la escala (tutor/ profesor de materia/ orientador/ profesor de apoyo/ especialista en altas capacidades/ otro); y respecto a la persona valorada: sexo, edad, curso, cuanto tiempo hace que lo conoce, rendimiento, evaluación psicopedagógica y tests de los que disponen de información sobre el alumno/a.

La escala estuvo disponible entre abril y diciembre de 2022. Se buscó la colaboración de los participantes a través de las asociaciones de padres y madres con niños y jóvenes con altas capacidades (58), centros educativos e instituciones quienes recibieron una carta en la que se les explicaban los detalles del estudio, la escala y las características de su colaboración. También se solicitó la participación a través de las Redes Sociales. En todos los casos la colaboración fue voluntaria y anónima.

Naturalmente no se pretendía con este procedimiento lograr una muestra aleatoria, estadísticamente representativa del conjunto de los profesores de la etapa de Educación Infantil. Para el propósito del estudio, que es aportar evidencias iniciales de la validez y estructura de la escala, es suficiente que la muestra tenga adecuada amplitud y varianza.

Análisis de datos

Para lograr evidencias de la validez de constructo se utilizó la técnica de Análisis Factorial Confirmatorio (AFC), utilizando el modelo original, compuesto por cinco factores o dimensiones: Intelectual, Académica, Creativa, Artística y Motivación, como referencia inicial (M1 y M2). Además, se han probado un modelo unidimensional (M3) y otro de cuatro dimensiones que fusiona las aptitudes intelectuales y académicas (M4) y algunas variaciones con factores de segundo orden (M5 y M6). En la siguiente tabla se incluye una descripción de los seis modelos factoriales estimados.

| Modelo | Estructura | Especificación |

| M1 | 5 Factores | Modelo original. Estimación (ULSMV) |

| M2 | 5 Factores | Modelo original. Estimación (MLMV) |

| M3 | 1 Factor | Modelo Unidimensional |

| M4 | 4 Factores | Unión en un factor de Intelectual y Académica |

| M5 | 5 Factores | + Factor 2º Orden (Intelectual-Académica) |

| M6 | 4 Factores | + Factor 2º Orden (Cognitiva-Creativa) |

Las escalas Likert de más de 5 puntos pueden lograr distribuciones con características métricas (Viladrich et al., 2017), no obstante, antes de comenzar con el estudio confirmatorio se analizó la posible falta de normalidad tanto univariada como multivariada. La primera con el estadístico de Shapiro-Wilk y, la segunda, con los estadísticos de simetría y curtosis de Mardia. En ambos casos, valores significativos indicarían falta de normalidad. También se presentan estadísticos descriptivos de los ítems, incluyendo información de tendencia central (medida y mediana), de dispersión (desviación típica) y también de discriminación (correlación ítem-total).

La estrategia del análisis factorial parte de la consideración inicial del nivel de medida de los ítems. En el caso de este tipo de ítems, si su métrica es ordinal, por lo que lo recomendable es utilizar correlaciones policóricas (Lloret-Segura et al., 2014 y Gaskin y Happell, 2014). En cambio, si puede asumirse una distribución cuantitativa de los datos, aunque su forma tenga cierta asimetría, podría emplearse la matriz de correlaciones de Pearson como base del estudio factorial.

Por otra parte, el método de estimación de los parámetros del modelo factorial debe ajustarse así mismo a la métrica de los ítems. En el caso de distribuciones ordinales la opción de mínimos cuadrados no ponderados robustos (ULSMV) es la que produce mejores resultados con muestras no muy grandes (Xia, 2016). Este modelo conlleva la definición de un mayor número de parámetros ya que la respuesta a los ítems se define de forma no lineal, a través de ecuaciones de regresión probit. En el caso de que pudiéramos asumir distribuciones cuantitativas, los estimadores más adecuados serían entonces de máxima verosimilitud y, en el caso específico de escalas Likert con un alto número de categorías, las versiones robustas han mostrado buen funcionamiento (Li, 2016), por ejemplo el que ajusta por media y varianza (MLMV). Todos los modelos asumen la existencia de correlación entre los diferentes factores.

De acuerdo con lo anterior, los dos primeros modelos (M1 y M2) fueron estimados con la misma estructura factorial, pero diferente matriz de correlaciones y estimadores. El M1 utiliza un modelo para ítems ordinales (correlaciones policóricas y estimadores ULSMV) y el M2 los considera cuantitativos pero con distribuciones asimétricas (correlaciones de Pearson y estimadores MLMV). El resto de los modelos probados utilizan la estrategia que proporcione mejores resultados en la primera comparación.

En la fase de evaluación del modelo, se utilizaron los índices estandarizados: Chi-cuadrado robusto normalizado (χ2/gl.), para valorar el ajuste global, donde valores entre 3 y 5 se consideran aceptables; RMSEA, para valorar la matriz residual, que es aceptable con valores inferiores a .08; CFI (Comparative Fit Index) y TLI (Tucker-Lewis Index), de ajuste comparativo, que resultan aceptables a partir de .90. Siguiendo a Hu y Bentler (1999), como evidencia de validez es suficiente un ajuste aceptable en la combinación de estos índices. También se calcularon en este caso los índices de modificación.

La dimensionalidad del constructo se refuerza con la interpretación de la relación entre factores latentes, así como con el estudio de la validez convergente de los factores, que señala la consistencia interna de los ítems que los componen. Se utilizó el promedio de la varianza explicada (Average Variance Extracted, AVE) y se complementó con los índices de fiabilidad compuesta.

El AVE se calculó sumando las cargas factoriales estandarizadas (Pi) al cuadrado (equivalente a R2) y dividiendo por el total ítems de la dimensión como se indica en la fórmula (1).

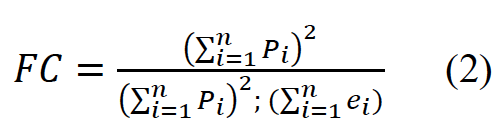

La Fiabilidad Compuesta (FC), se estimó a partir de las cargas factoriales y de la varianza de error (ei) con la fórmula (2), de la siguiente manera:

Donde la varianza de error de un ítem es el resultado de restar de 1 su carga factorial al cuadrado, según se indica en la fórmula (3).

[1-]

[1-]Valores de .5 o más de AVE señalan que el factor consigue explicar el 50% o más de variabilidad de las respuestas a los ítems que lo componen. Combinando este estadístico con fiabilidades compuestas superiores a .7 puede asumirse la validez convergente de los factores.

Finalmente, se analizaron los tamaños de los pesos factoriales estandarizados de cada ítem. Valores entre .6 y .8 son buenos, tratando de lograr también ese 50% de variabilidad explicada de las respuestas a cada ítem. Como complemento se observaron los índices de modificación asociados a posibles cambios en los parámetros que identifican la relación entre el ítem y el factor.

Las estimaciones de los parámetros de los distintos modelos factoriales confirmatorios se llevaron a cabo con el software MPlus 8.1 (Muthen y Muthen, 2012-2017).

Resultados

En primer lugar, los estadísticos descriptivos de los ítems se muestran en la Tabla 4. Se puede observar que la media es bastante alta, en la mayor parte supera los 7 e incluso 8 puntos. El único ítem con una media por debajo de 6 puntos es el I9 ('Se resiste a desanimarse ante los obstáculos o problemas'). El I5 ('Aprende nueva información rápidamente') y el I27 ('Demuestra buena memoria recordando hechos y detalles') logran las valoraciones más altas, con medianas de 9 puntos y distribuciones muy homogéneas con desviaciones típicas inferiores a 1. Además, la media total de la escala es de 7.2 puntos (D.T.=1) y la mediana, en promedio, se sitúa en 7.4 puntos.

Observando la correlación entre cada ítem y el total, la tendencia es positiva. Todos los ítems miden en el mismo sentido y los valores varían entre .4 y .8, con un promedio de .61, resultado que indica la homogeneidad del conjunto de ítems. El estadístico de normalidad de cada ítem muestra una falta de cumplimiento de este supuesto en todos los casos.

| Ítems | N | Media | Mediana | DE | Mín. | Máx. | Shapiro-Wilk | p | Poliserial | |

| I1 | 134 | 7.94 | 8.0 | 1.28 | 2 | 9 | .781 | < .001 | .59 | |

| I2 | 134 | 7.74 | 8.0 | 1.40 | 3 | 9 | .802 | < .001 | .58 | |

| I3 | 134 | 6.82 | 7.0 | 1.73 | 2 | 9 | .911 | < .001 | .61 | |

| I4 | 134 | 8.13 | 8.0 | 1.01 | 4 | 9 | .777 | < .001 | .55 | |

| I5 | 134 | 8.36 | 9.0 | .96 | 4 | 9 | .667 | < .001 | .57 | |

| I6 | 134 | 7.60 | 8.0 | 1.17 | 4 | 9 | .890 | < .001 | .59 | |

| I7 | 134 | 7.73 | 8.0 | 1.29 | 2 | 9 | .845 | < .001 | .39 | |

| I8 | 134 | 6.58 | 7.0 | 2.20 | 1 | 9 | .890 | < .001 | .68 | |

| I9 | 134 | 5.81 | 6.0 | 2.17 | 1 | 9 | .941 | < .001 | .58 | |

| I10 | 134 | 7.70 | 8.0 | 1.16 | 4 | 9 | .836 | < .001 | .63 | |

| I11 | 134 | 7.40 | 8.0 | 1.84 | 1 | 9 | .801 | < .001 | .68 | |

| I12 | 134 | 7.70 | 8.0 | 1.18 | 3 | 9 | .844 | < .001 | .60 | |

| I13 | 134 | 7.94 | 8.0 | 1.25 | 2 | 9 | .779 | < .001 | .67 | |

| I14 | 134 | 7.83 | 8.0 | 1.12 | 4 | 9 | .838 | < .001 | .49 | |

| I15 | 134 | 7.80 | 8.0 | 1.22 | 4 | 9 | .832 | < .001 | .65 | |

| I16 | 134 | 6.87 | 7.0 | 2.12 | 1 | 9 | .869 | < .001 | .74 | |

| I17 | 134 | 6.72 | 7.0 | 1.87 | 1 | 9 | .918 | < .001 | .69 | |

| I18 | 134 | 7.64 | 8.0 | 1.33 | 4 | 9 | .860 | < .001 | .52 | |

| I19 | 134 | 6.51 | 7.0 | 1.97 | 1 | 9 | .920 | < .001 | .70 | |

| I20 | 134 | 6.81 | 7.0 | 1.92 | 1 | 9 | .888 | < .001 | .72 | |

| I21 | 134 | 7.22 | 7.0 | 1.31 | 3 | 9 | .904 | < .001 | .59 | |

| I22 | 134 | 7.95 | 8.0 | 1.17 | 4 | 9 | .817 | < .001 | .48 | |

| I23 | 134 | 7.73 | 8.0 | 1.41 | 1 | 9 | .813 | < .001 | .54 | |

| I24 | 134 | 6.64 | 7.0 | 2.02 | 1 | 9 | .898 | < .001 | .72 | |

| I25 | 134 | 8.11 | 8.0 | 1.14 | 3 | 9 | .740 | < .001 | .54 | |

| I26 | 134 | 6.27 | 7.0 | 2.11 | 1 | 9 | .924 | < .001 | .70 | |

| I27 | 134 | 8.44 | 9.0 | .93 | 4 | 9 | .637 | < .001 | .47 | |

| I28 | 134 | 6.32 | 6.0 | 1.96 | 1 | 9 | .931 | < .001 | .76 | |

| I29 | 134 | 7.97 | 8.0 | 1.11 | 3 | 9 | .813 | < .001 | .53 | |

| I30 | 134 | 7.40 | 8.0 | 1.61 | 1 | 9 | .862 | < .001 | .37 | |

| I31 | 134 | 7.72 | 8.0 | 1.49 | 2 | 9 | .803 | < .001 | .54 | |

| I32 | 134 | 7.40 | 7.5 | 1.26 | 3 | 9 | .903 | < .001 | .66 | |

| I33 | 134 | 6.31 | 6.0 | 1.98 | 1 | 9 | .933 | < .001 | .74 | |

| I34 | 134 | 6.38 | 7.0 | 2.03 | 1 | 9 | .923 | < .001 | .73 | |

| I35 | 134 | 7.19 | 7.5 | 1.73 | 1 | 9 | .868 | < .001 | .71 | |

| I36 | 134 | 7.02 | 7.0 | 1.57 | 1 | 9 | .905 | < .001 | .71 | |

| I37 | 134 | 7.57 | 8.0 | 1.30 | 3 | 9 | .873 | < .001 | .60 | |

| I38 | 134 | 6.10 | 6.0 | 1.91 | 1 | 9 | .938 | < .001 | .67 | |

| I39 | 134 | 7.42 | 8.0 | 1.67 | 1 | 9 | .844 | < .001 | .64 | |

| I40 | 134 | 7.07 | 7.0 | 1.58 | 1 | 9 | .905 | < .001 | .62 | |

| I41 | 134 | 6.08 | 6.0 | 1.94 | 1 | 9 | .944 | < .001 | .69 | |

| I42 | 134 | 6.10 | 6.0 | 1.86 | 1 | 9 | .944 | < .001 | .72 | |

| I43 | 134 | 7.21 | 7.0 | 1.66 | 2 | 9 | .882 | < .001 | .59 | |

| I44 | 134 | 7.28 | 7.0 | 1.24 | 3 | 9 | .914 | < .001 | .63 | |

| I45 | 134 | 8.17 | 8.0 | 1.04 | 4 | 9 | .761 | < .001 | .60 | |

| I46 | 134 | 7.33 | 7.5 | 1.54 | 1 | 9 | .872 | < .001 | .55 | |

| I47 | 134 | 7.37 | 8.0 | 1.37 | 3 | 9 | .900 | < .001 | .56 | |

| I48 | 134 | 6.01 | 6.0 | 2.22 | 1 | 9 | .937 | < .001 | .70 | |

| I49 | 134 | 7.50 | 8.0 | 1.34 | 3 | 9 | .877 | < .001 | .69 | |

| I50 | 134 | 7.31 | 8.0 | 1.72 | 1 | 9 | .827 | < .001 | .65 | |

También los resultados de la prueba de normalidad multivariada, que se muestran en la Tabla 5, con valores de simetría y curtosis multivariada señalan la falta del complimiento del supuesto, lo que obligará a considerar este aspecto en la estimación de los modelos, tal como hemos señalado en el apartado de análisis de datos.

| Valor | Estadístico* | gl | p | |

| Simetría | 1924 | 28905 | 22100 | < .001 |

| Curtosis | 2802 | 16,2 | < .001 |

En la tabla 6 se incluyen los resultados de ajuste de los seis modelos confirmatorios estudiados. Recordemos que los dos primeros (M1 y M2) estiman el modelo de cinco factores mediante estrategias analíticas diferentes, la primera ajustada al formato ordinal de los ítems y, la segunda, considerándolos cuantitativos pero con distribuciones asimétricas. El M3 asume un único rasgo latente. El M4 hace referencia al modelo de cuatro factores que une los ítems de las dimensión intelectual y académica. Finalmente, el M5 y el M6 incluyen factores de segundo orden en el modelo. El M5 prueba la existencia de un factor común para explicar los resultados de las capacidades intelectuales y académicas, es decir, es una variación del M1 pero con el factor de segundo orden. Y, finalmente, el M6 replica el M4, de cuatro factores, pero añadiendo un factor de segundo orden que combine las dimensiones cognitiva y creativa.

| M1 | M2 | M3 | M4 | M5 | M6 | |

| c2 | 1680 | 1494 | 2378.00 | 1687.96 | 1677.65 | 1749.99 |

| gl | 1165 | 1165 | 1175 | 1169 | 1167 | 1170 |

| p | <.001 | <.001 | <.001 | <.001 | <.001 | <.001 |

| c2/gl | 1.442 | 1.283 | 2.024 | 1.444 | 1.438 | 1.496 |

| RMSEA | 0.057 | 0.046 | 0.100 | 0.058 | 0.057 | 0.061 |

| RMSEA (LI) | 0.051 | 0.039 | 0.095 | 0.051 | 0.051 | 0.055 |

| RMSEA (LS) | 0.063 | 0.053 | 0.105 | 0.064 | 0.063 | 0.067 |

| CFI | 0.92 | 0.78 | 0.76 | 0.92 | 0.92 | 0.91 |

| TLI | 0.93 | 0.82 | 0.71 | 0.92 | 0.90 | 0.92 |

El M1 y M2 utilizan el modelo original de cinco factores o dimensiones (Intelectual, Académica, Creatividad, Artística y Motivación) pero varían el método de estimación de los parámetros, como se ha señalado. El primero considera una métrica ordinal de los ítems (correlaciones policóricas y estimación ULSMV) y, el segundo, los trata como cuantitativos pero con distribuciones algo alejadas de la normalidad (correlaciones de Pearson y estimación MLMV).

En el M1, los índices de ajuste comparado (CFI y TLI) logran unos valores aceptables (>.92), el índice basado en los residuos (RMSEA) se encuentra en el límite de los valores óptimos (<.06) y el valor del ajuste global, considerando 2 normalizado, también señala un buen ajuste (< 3). Si observamos el M2, el ajuste global y los residuos mejoran sustancialmente, sin embargo, el ajuste comparativo no consigue unos valores aceptables. Por este motivo, el resto de los modelos se estimaron empleando la metodología de estimación del M1, como señalamos en el párrafo anterior.

Si observamos la Tabla 7, los valores de correlación entre dimensiones obtenidas en el M1, las dimensiones de aptitudes académicas y capacidades intelectuales están altamente correlacionadas (.998), lo que puede sugerir un mismo significado de estas dos dimensiones. Este modelo se probó en el M4 y los valores de ajuste son similares al M1.

El M3, que prueba la posible unidimensionalidad del constructo, no logra, como era de esperar, unos valores aceptables de los índices de ajuste comparativos (CFI y TFL < .9), tampoco los residuales de las matrices de correlación observadas y estimadas (RMSEA > .08).

La estructura de cuatro factores definida en el M4 logra un resultado de ajuste similar al M1. Por lo que un factor para explicar el conjunto de respuestas de los ítems de capacidades intelectuales y académicas también podría confirmarse. El M5 también apunta hacia ese factor común.

En los modelos de cinco factores (M1 y M5), la dimensión de capacidades académicas, como puede observarse en la Tabla 8, es el único que no logra un AVE igual o superior a .5, es decir, explica al menos el 50% de la variabilidad de las respuestas a los ítems que lo componen. Aunque el indicador de consistencia interna (fiabilidad compuesta) está muy cerca de .9. El resto de las dimensiones están por encima de ese .9. Además, en el M5 la estimación produce un peso factorial por encima de 1 en el factor de segundo orden. Este fenómeno se produce en la relación entre el factor intelectual y la dimensión académica, lo que produce un varianza de error negativa. Esto puede estar producido por el tamaño muestral, aunque suficiente para estimar 4 o 5 dimensiones con las características de estos modelos (más de 8 ítems por dimensión y pesos factoriales superiores a .6), tiene problemas con la estimación de los efectos de este modelo más complejo.

En estos modelos (M1 y M5), el ítem 30 (de la dimensión académica) tiene un R2 inferior a .3 (ver Tabla 9), valor que mejora ligeramente en el modelo que une los factores intelectual y académico (M4). También el AVE de este factor y la fiabilidad compuesta son buenos. Cambiar este ítem al factor intelectual, o descartarlo, pueden ser opciones que mejoren el ajuste.

Finalmente, en el M6 el ajuste empeora ligeramente respecto al M1 y M4. Aunque la hipótesis de un posible factor de segundo orden que explique las respuestas del factor cognitivo (intelectual-académico) y la creatividad podría sostenerse, porque los valores de ajuste siguen siendo aceptables. Sin embargo, considerando estos valores, especificar dimensiones separadas para los aspectos cognitivos y los creativos es lo más adecuado.

| Intelectual | Académica | Creativa | Artística | Motivación | |

| Intelectual | 1 | ||||

| Académica | .998 | 1 | |||

| Creativa | .734 | .813 | 1 | ||

| Artística | .409 | .467 | .598 | 1 | |

| Motivación | .622 | .688 | .557 | .657 | 1 |

Respecto a la validez convergente, la tabla 8 incluye los valores del promedio de varianza explicada (AVE) del conjunto de ítems de cada factor; también incorpora la información sobre la fiabilidad compuesta para estudiar la consistencia interna de cada grupo de ítems.

Los resultados muestran unos buenos valores, excepto las particularidades mencionadas más arriba sobre el factor académico en los modelos M1 y M5. El factor artístico es el que mejor explica las respuestas a los diferentes ítems que lo componen, logra valores de AVE superiores a .7; es decir, más del 70% de variabilidad explicada en todos los modelos. El factor motivacional explica más del 60% de la variabilidad de las respuestas y, en el M1, las capacidades intelectuales también tienen el mismo AVE. Sin embargo, este valor disminuye un 10% al fusionarlo con las capacidades académicas en el M4. El factor de creatividad consigue explicar aproximadamente el 60% de la variabilidad de las respuestas a los ítems que lo componen.

Un resultado a destacar son los buenos valores de fiabilidad compuesta que apoyan la estructura multidimensional del modelo con valores superiores a .9. Contar con un número elevado de ítems en cada factor ayuda a lograr este resultado.

| Promedio de la Varianza explicada (AVE) | |||||||

| Dimensiones | M1 | M2 | M3 | M4 | M5 | M6 | |

| Intelectual | .64 | .58 | .54 | .64 | .54 | ||

| Académica | .45 | .41 | .45 | ||||

| Creativa | .59 | .55 | .59 | .59 | .59 | ||

| Artística | .74 | .72 | .74 | .74 | .74 | ||

| Motivación | .64 | .58 | .64 | .64 | .64 | ||

| Total | .61 | .57 | .43 | .63 | .61 | .63 | |

| Fiabilidad Compuesta | |||||||

| Intelectual | .95 | .93 | .96 | .95 | .96 | ||

| Académica | .89 | .87 | .89 | ||||

| Creativa | .94 | .88 | .94 | .94 | .94 | ||

| Artística | .96 | .96 | .96 | .96 | .96 | ||

| Motivación | .95 | .94 | .95 | .95 | .95 | ||

| Total | .97 | ||||||

Finalmente, en la tabla 9 se incluyen los pesos factoriales, la variabilidad explicada de cada ítem en términos de R2 y el error de medida. Destaca el alto valor de los coeficientes en todas las dimensiones, excepto los valores por debajo de .6 del peso factorial del ítem 30 ('Comprende material escrito') en la dimensión académica. También la estimación del efecto del factor sobre el ítem 7 ('Demuestra amplios conocimientos sobre uno o más temas') está por debajo de ese valor (.557), resultados que apoyan la adecuación de la muestra utilizada.

| Factor | Ítem | b | R2 | Error |

| Intelectual | I2 | .80 | .63 | .37 |

| I4 | .76 | .57 | .43 | |

| I5 | .84 | .70 | .30 | |

| I13 | .85 | .72 | .28 | |

| I14 | .68 | .46 | .54 | |

| I15 | .82 | .67 | .33 | |

| I27 | .75 | .56 | .44 | |

| I29 | .79 | .62 | .38 | |

| I32 | .87 | .75 | .25 | |

| I45 | .84 | .71 | .29 | |

| Académica | I1 | .76 | .58 | .42 |

| I7 | .56 | .31 | .69 | |

| I10 | .76 | .58 | .42 | |

| I18 | .63 | .40 | .60 | |

| I22 | .63 | .39 | .61 | |

| I25 | .74 | .55 | .45 | |

| I30 | .53 | .28 | .72 | |

| I31 | .69 | .48 | .52 | |

| I39 | .67 | .44 | .56 | |

| I43 | .67 | .45 | .55 | |

| Creatividad | I6 | .73 | .53 | .47 |

| I12 | .76 | .57 | .43 | |

| I21 | .76 | .57 | .43 | |

| I23 | .73 | .53 | .47 | |

| I36 | .83 | .68 | .32 | |

| I37 | .74 | .54 | .46 | |

| I40 | .77 | .59 | .41 | |

| I44 | .83 | .68 | .32 | |

| I47 | .77 | .59 | .41 | |

| I49 | .81 | .65 | .35 | |

| Factor | Ítem | b | R2 | Error |

| Artística | I3 | .74 | .55 | .45 |

| I17 | .82 | .68 | .32 | |

| I19 | .87 | .76 | .24 | |

| I28 | .95 | .89 | .11 | |

| I33 | .93 | .86 | .14 | |

| I34 | .91 | .83 | .17 | |

| I38 | .83 | .69 | .31 | |

| I41 | .87 | .76 | .24 | |

| I42 | .90 | .80 | .20 | |

| I46 | .72 | .52 | .48 | |

| Motivación | I8 | .78 | .61 | .39 |

| I9 | .64 | .40 | .60 | |

| I11 | .85 | .72 | .28 | |

| I16 | .87 | .75 | .25 | |

| I20 | .82 | .67 | .33 | |

| I24 | .81 | .65 | .35 | |

| I26 | .79 | .62 | .38 | |

| I35 | .84 | .71 | .29 | |

| I48 | .79 | .63 | .37 | |

| I50 | .80 | .64 | .36 |

Discusión

Hemos sometido a prueba seis modelos que expresan variantes sobre la estructura original de cinco factores de la escala y el modelo unidimensional, que sirve de contraste para el ajuste de los demás. Se ha comparado la métrica ordinal y la cuantitativa y, como era esperable, se obtiene un mejor resultado con la opción ordinal y estimación ULSMV (M1), frente a la estimación cuantitativa (M2); por ello, los demás modelos probados se hacen con esta estimación.

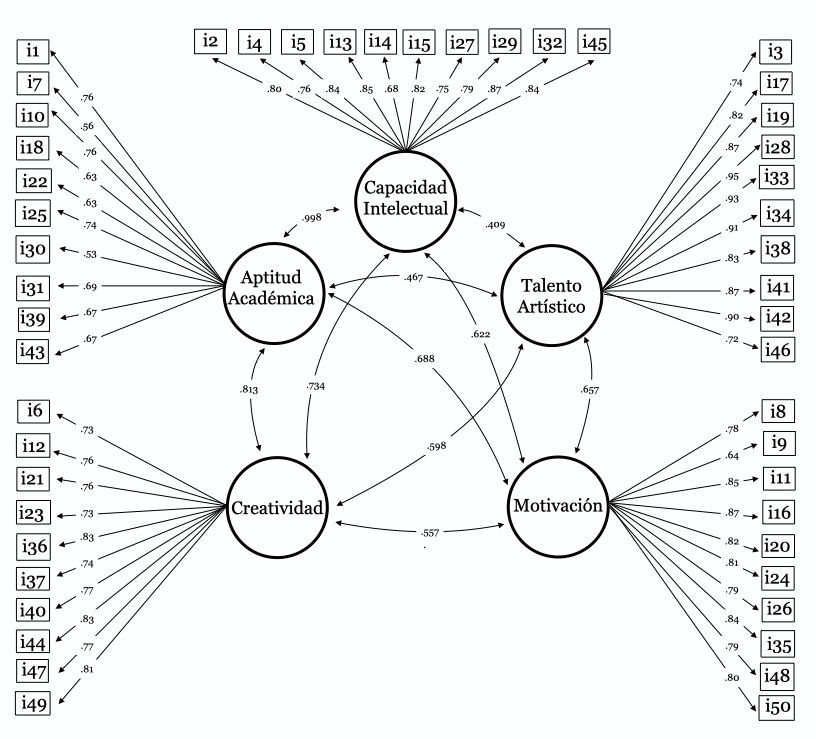

Los resultados obtenidos muestran una bondad de ajuste adecuada del modelo de cinco factores con el que se ha diseñado la escala (ver Fig. 1), no obstante, hay otras variantes que ofrecen cierta plausibilidad y que podrían ser defendibles desde un punto de vista empírico, de acuerdo con los índices de ajuste y los resultados de AVE y la fiabilidad.

Figura 1.

Representación del modelo M1 adoptado

En el modelo 1 se observa una correlación particularmente alta entre las capacidades intelectuales y académicas, que podrían llevarnos a pensar que se está midiendo una misma dimensión latente, por lo que podrían unirse en una sola dimensión. Este es el caso del modelo 4, que une las dimensiones intelectual y académica reduciendo el modelo a cuatro factores, o el modelo 5 que plantea un factor de segundo orden que une estas dos dimensiones de primer orden. Por su parte, el modelo 6 que une en un factor de segundo orden, incluyendo también las capacidades creativas, aunque esta es peor opción por sus valores de ajuste.

La opción tomada, al menos de manera provisional, de optar por el modelo 1, está justificada por la bondad de ajuste (CFI, .92; TLI, .93 y RMSEA, .057), fiabilidad (.89-.96) y varianza explicada por los factores (.45-.74). No obstante, quedan algunos aspectos que no son conclusivos, como es optar por el modelo 4 o incluso por el 5, que se podrían justificar empíricamente. Teniendo en cuenta que el modelo original ajusta de manera adecuada, lo proponemos como solución a este estudio, dejando para ulteriores comprobaciones modelos alternativos distintos de los explorados aquí.

Con los datos a nuestro alcance parece que es mejor optar por la cautela. Sin embargo, quizá los resultados pudieran indicar que los profesores de este nivel educativo no establecen una clara diferencia entre lo que la escala determina como capacidades intelectuales y académicas, de hecho, la correlación entre ambas dimensiones es casi perfecta (.998). Este aspecto habrá que verificarlo en otras investigaciones posteriores. De hecho, algunos estudios sobre la GRS (Benson y Kranzler, 2018) cuestionaban la dimensionalidad de la escala, sugiriendo un único factor, cosa que no es compatible con nuestros resultados (M3). Además, la solvencia del desarrollo del instrumento desde el punto de vista conceptual y educativo es reconocido por diversos autores (Margulies y Floyd, 2004).

Hasta el momento no existen datos de validación de esta escala (GRS 2) en otros países, sí de su predecesora la GRS. Hay tres estudios de traducción y validación en China, Turquía y Grecia para la versión anterior de la escala Preschool/Kindergarten Form que aquí se valida. Estos estudios reflejan buenos valores respecto a la fiabilidad y la validez de la estructura original de cinco factores (Siu, 2010; Karadag, et al., 2016; Sofologi, et al., 2022).

La determinación de la estructura tiene consecuencias prácticas para el uso de la escala, pues se puede utilizar una puntuación para cada dimensión o bien una puntuación global, cuestión que debe ser abordada en nuevos estudios. No obstante, desde el punto de vista del diagnóstico siempre se prefieren indicadores específicos (dimensiones) que puntuaciones globales que pueden enmascarar diferencias relevantes.

Cada proceso de validación de un instrumento requiere, naturalmente, de más de un estudio para generalizar conclusiones, pero los resultados obtenidos en este primer análisis apoyan la estructura original propuesta por los autores de la Escala. Sí hemos valorado que quizá sería interesante reconsiderar el ítem 30 ('Comprende material escrito') que forma parte del factor Aptitud Académica y ver si ajusta mejor en otra dimensión o requiere una revisión de su redacción.

Lo que si será imprescindible es continuar con el proceso de validación e incluso baremación para la población española de esta escala para que, en esta etapa de los primeros años tan crucial, los docentes de Infantil puedan disponer de una herramienta útil, fiable y válida que les ayude en su tarea de detección y desarrollo del potencial de sus alumnos, y que vendrá a unirse con las ya validadas para padres y profesores (Tourón, et al., 2023a y 2023b).

En suma, este trabajo logra aporta evidencias sustantivas respecto a la estructura factorial y propiedades psicométricas de la escala estudiada, cumpliendo así el objetivo central del mismo, dejando abierto el camino para futuros estudios que aporten nuevas evidencias que consoliden los resultados aquí obtenidos.

Agradecimientos

Esta investigación ha recibido apoyo financiero del Vicerrectorado de Investigación de la Universidad Internacional de La Rioja.

Agradecemos el apoyo del profesor Steven Pfeiffer, que nos proporcionó los ítems de la versión en desarrollo de GRS-2 para esta investigación.

Referencias

Abdulla, A. M., & Cramond, B. (2017). After Six Decades of Systematic Study of Creativity: What do Teachers Need to Know About What it is and How it is Measured? Roeper Review, 39(1), 9-23. https://doi.org/10.1080/02783193.2016.1247398

Beghetto, R. A., & Plucker, J. A. (2016). Revisiting the Relationship Among Schooling, Learning, and Creativity. In J. C. Kaufman & J. Baer (Eds.), Creativity and Reason in Cognitive Development (pp. 72–91). Cambridge University Press. https://doi.org/10.1017/CBO9781139941969.005

Benson, N. F., & Kranzler, J. H. (2018). Another Look at the Construct Validity of the Gifted Rating Scales: Preschool/kindergarten and School Forms. Journal of Psychoeducational Assessment, 36(8), 782-797. https://doi.org/10.1177/0734282917710377

Bishop, G. F. (2011). Item Order Randomization. In P. J. Lavrakas. Encyclopedia of Survey Research Methods, (pp. 397-399). SAGE. https://doi.org/10.4135/9781412963947.n255

Bloom, B. (1985). Developing Talent in Young People. Ballantine Books.

Bloom, B. S. (1982). The Role of Gifts and Markers in the Development of Talent. Exceptional Children, 48(6), 510-522. https://doi.org/10.1177/001440298204800607

Clinkenbeard, P. R. (2012). Motivation and gifted students: Implications of theory and research. Psychology in the Schools, 49(7), 622-630. https://doi.org/10.1002/pits.21628

Cropley, A. J. (2000). Defining and Measuring Creativity: Are Creativity Tests Worth Using? Roeper Review, 23(2), 72-79. https://doi.org/10.1080/02783190009554069

Cropley, A. J., & Urban, K. K. (2000). Programs and Strategies for Nurturing Creativity. In K. A. Heller, F. J. Mönks, R. Subotnik, Robert Sternberg (Eds.), International Handbook of Giftedness and Talent (2nd ed., pp. 485-498). Pergamon Press. https://doi.org/10.1016/B978-008043796-5/50034-6

Csikszentmihalyi, M., & Wolfe, R. (2000). New Conceptions and Research Approaches to Creativity: Implications of a Systems Perspective for Creativity in Education. In K. A. Heller, F. J. Mönks, R. Subotnik, Robert Sternberg (Eds.), International Handbook of Giftedness and Talent (2nd ed., pp. 81-93). Pergamon Press. https://doi.org/10.1016/B978-008043796-5/50006-1

Dai, D. Y. (2018). A History of Giftedness: Paradigms and Paradoxes. In S. I. Pfeiffer (Ed.), Handbook of Giftedness in Children (2nd. ed., pp. 1-14). Springer. https://doi.org/10.1007/978-3-319-77004-8_1

Duckworth, A. (2016). Grit: The Power of Passion and Perseverance. Scribner/Simon & Schuster.

Duckworth, A. L., & Seligman, M. E. (2005). Self-discipline outdoes IQ in predicting academic performance of adolescents. Psychological science, 16(12), 939-944. https://doi.org/10.1111/j.1467-9280.2005.01641.x

Dweck, C. S. (1999). Self-Theories: Their Role in Motivation, Personality, and Development. Psychology Pres.

Dweck, C. S. (2006). Mindset: The New Psychology of Success. Random House.

Gagné, F. (1993). Constructs and Models Pertaining to Exceptional Human Abilities. In K. A. Heller, F. J. Mönks, & A. H. Passow (Eds.), International Handbook of Research and Development of Giftedness and Talent (pp. 69–87). Pergamon Press.

Gaskin, C. J., & Happell, B. (2014). On Exploratory Factor Analysis: A Review of Recent Evidence and Assessment of Current Practice, and Recommendations for Future Use. International Journal of Nursing Studies, 51(3), 511-521. https://doi.org/10.1016/j.ijnurstu.2013.10.005

Hargreaves, D. J., Galton, M. J., & Robinson, S. (1996). Teachers’ Assessments of Primary Children’s Classroom Work in the Creative Arts. Educational Research, 38(2), 199–211. https://doi.org/10.1080/0013188960380207

Haroutounian, J. (1995). Talent Identification and Development in the Arts: An Artistic/Educational Dialogue. Roeper Review, 18 (2), 112–117. https://doi.org/10.1080/02783199509553710

Haroutounian, J. (2003). Musical Talent: Nurturing Potential and Guiding Development. In P. Olszewski-Kubilius, L. Limburg-Weber & S. I. Pfeiffer (Eds.), Early Gifts: Recognizing and Nurturing Children's Talents, (pp. 83-102). Prufrock Press.

Harrison, C. (2004). Giftedness in Early Childhood: The Search for Complexity and Connection. Roeper Review, 26(2), 78-84. https://doi.org/10.1080/02783190409554246

Hodge, K. A., & Kemp, C. R. (2000). Exploring the Nature of Giftedness in Preschool Children. Journal for the Education of the Gifted, 24(1), 46-73. https://doi.org/10.1177/016235320002400103

Hollingworth, L. S. (1942). Children Above 180 IQ, Stanford-Binet; Origin and Development. The World Dood Company. https://doi.org/10.1037/13574-000

Hu, L. T., & Bentler, P. M. (1999). Cutoff Criteria for Fit Indexes in Covariance Structure Analysis: Conventional Criteria versus New Alternatives. Structural Equation Modeling, 6(1), 1–55. https://doi.org/10.1080/10705519909540118

Jackson, N. E. (2003). Young Gifted Children. In N. Colangelo & G. A. Davis (Eds.), Handbook of Gifted Education (3rd Ed., pp. 470-482). Allyn & Bacon.

Jarosewich, T., Pfeiffer, S. I., & Morris, J. (2002). Identifying Gifted Students Using Teacher Rating Scales: A Review of Existing Instruments. Journal of Psychoeducational Assessment, 20(4), 322-336. https://doi.org/10.1177/073428290202000401

Karadag, F., Karabey, B., & Pfeiffer, S. (2016). Identifying Gifted Preschoolers in Turkey: The Reliability and Validity of the Turkish-Translated Version of the GRS-Preschool/Kindergarten Form. Journal of Education and Training Studies, 4(10), 8-16. https://doi.org/10.11114/jets.v4i10.1686

Kozbelt, A. (2019). Reflections on Talent Development in the Performing Arts: Concluding Comments. In R. F. Subotnik, P. Olszewski-Kubilius, & F. C. Worrell (Eds.), The psychology of High Performance: Developing Human Potential into Domain-Specific Talent (pp. 301–307). American Psychological Association. https://doi.org/10.1037/0000120-014

Li, C. H. (2016). Confirmatory Factor Analysis with Ordinal Data: Comparing Robust Maximum Likelihood and Diagonally Weighted Least Squares. Behavior Research Methods, 48, 936-949. https://doi.org/10.3758/s13428-015-0619-7

Lloret-Segura, S., Ferreres-Traver, A., Hernández-Baeza, A., & Tomás-Marco, I. (2014). [Exploratory Item Factor Analysis: a practical guide revised and updated]. Annals of Psychology, 30(3), 1151-1169. https://doi.org/10.6018/analesps.30.3.199361

Margulies, A. S., & Floyd, R. G. (2004). Book review: Gifted Rating Scales (GRS). Journal of Psychoeducational Assessment, 22(3), 275-282. https://doi.org/10.1177/073428290402200306

McLean, M., Sandall, S.R., Smith, B.J. (2016). A History of Early Childhood Special Education. In B. Reichow, B. Boyd, E. Barton, S. Odom, (Eds.), Handbook of Early Childhood Special Education. Springer, Cham.

Morelock, M. J., & Feldman, D. H. (1992). The Assessment of Giftedness in Preschool Children. In E. V. Nuttall, I. Romero, & J. Kalesnik, (Eds.), Assessing and Screening Preschoolers: Psychological and Educational Dimensions (pp. 301-309). Allyn & Bacon.

Muthén, L. K., & Muthén, B. O. (2012-2017). Mplus User's Guide. Eighth Edition. Muthén & Muthén.

Olszewski-Kubilius, P. M. (2000). The Transition from Childhood Giftedness to Adult Creative Productiveness: Psychological Characteristics and Social Supports. Roeper Review, 23, 65–71. https://doi.org/10.1080/02783190009554068

Olszewski-Kubilius, P., Subotnik, R. F., & Worrell, F. C. (2015). Antecedent and Concurrent Psychosocial Skills that Support High Levels of Achievement Within Talent Domains. High Ability Studies, 26(2), 195-210. https://doi.org/10.1080/13598139.2015.1095077

Olszewski-Kubilius, P., Worrell, F. C., Subotnik, R. F., & Foley-Nicpon, M. (2019). Reflections on Talent Development in Academics. In R. F. Subotnik, P. Olszewski-Kubilius, & F. C. Worrell (Eds.), The Psychology of High Performance: Developing Human Potential into Domain-Specific Talent (pp. 225–236). American Psychological Association. https://doi.org/10.1037/0000120-011

Pfeiffer, S. I. (2002). Identifying Gifted and Talented Students: Recurring Issues and Promising Solutions. Journal of Applied School Psychology, 1, 31-50. https://doi.org/10.1300/J008v19n01_03

Pfeiffer, S. I. (2015). Essentials of Gifted Assessment. John Wiley & Sons.

Pfeiffer, S. I., & Jarosewich, T. (2003). GRS: Gifted Rating Scales. Psychological Corporation.

Pfeiffer, S. I., & Petscher, Y. (2008). Identifying Young Gifted Children Using the Gifted Rating Scales- Preschool/Kindergarten Form. Gifted Child Quarterly, 52(1), 19-29. https://doi.org/10.1177/0016986207311055

Pfeiffer, S. I., & Reddy, L. A. (1998). School-Based Mental Health Programs: Present Status and Blueprint for the Future. School Psychology Review, 27, 84-96. https://doi.org/10.1080/02796015.1998.12085900

Pfeiffer, S. I., & Stocking, V. B. (2000). Vulnerabilities of Academically Gifted Students. Special Services in the Schools, 16(1-2), 83-93. https://doi.org/10.1300/J008v16n01_06

Pink, D. H. (2009). Drive: The surprising truth about what motives us. Riverhead Books.

Plucker, J.A., Guo, J., Makel, M.C. (2018). Creativity. In S. I. Pfeiffer (Ed.). Handbook of Giftedness in Children (81-99). Springer. https://doi.org/10.1007/978-3-319-77004-8_6

Porath, M. (1993). Gifted young artists: Developmental and individual differences. Roeper Review, 16(1), 29–33. https://doi.org/10.1080/02783199309553530

Presbury, J. H., Benson, A. J. & Torrance, E. P. (1997). Creativity. In G. G. Bear, K. M. Minke, & A. Thomas (Eds.), Children’s needs II: Development, Problems and Alternatives (pp. 449-456). National Association of School Psychologists.

Pressey, S. L. (1955). Concerning the Nature and Nurture of Genius. The Scientific Monthly, 81(3), 123-129.

Runco, M. A. (2014). “Big C, Little c” Creativity as a False Dichotomy: Reality is not Categorical. Creativity Research Journal, 26(1), 131-132. https://doi.org/10.1080/10400419.2014.873676

Ryan, R. M., & Deci, E. L. (2000). Intrinsic and extrinsic motivations: Classic definitions and new directions. Contemporary Educational Psychology, 25(1), 54–67. https://doi.org/10.1006/ceps.1999.1020

Sankar-DeLeeuw, N. (2002). Gifted Preschoolers: Parent and Teacher Views on Identification, Early Admission, and Programming. Roeper Review, 24, 172-177. https://doi.org/10.1080/02783190209554174

Schneider, W. (2000). Giftedness, Expertise, and (exceptional) Performance: A Developmental Perspective. In K. A. Heller, F. J. Mönks, R. J. Sternberg, & R. F. Subotnik (Eds.), International Handbook of Giftedness and Talent, (2nd. Ed., pp. 165-177). Elsevier. https://doi.org/10.1016/B978-008043796-5/50012-7

Shaughnessy, M. F. (2022). An Interview with Steven I. Pfeiffer: Gifted Rating Scales-(GRS [TM] 2). North American Journal of Psychology, 24(1), 1-1.

Silverman, L. K. (2018). Assessment of Giftedness. In S.I. Pfeiffer (Ed.), Handbook of Giftedness in Children (2nd.Ed., pp. 183-207). Springer. https://doi.org/10.1007/978-3-319-77004-8_12

Simonton, D. K. (2000). Creativity: Cognitive, Personal, Developmental, and Social Aspects. American Psychologist, 55(1), 151–158. https://doi.org/10.1037/0003-066X.55.1.151

Siu, A. F. (2010). The Reliability and Validity of a Chinese-Translated Version of the Gifted Rating Scale-Preschool/Kindergarten Form. Journal of Psychoeducational Assessment, 28(3), 249-258. https://doi.org/10.1177/0734282909345832

Sofologi, M., Papantoniou, G., Avgita, T., Lyraki, A., Thomaidou, C., Zaragas, H., Ntritsos, G., Varsamis, P., Staikopoulos, K., Kougioumtsis, G., Papantoniou, A. & Moraitou, D. (2022). The Gifted Rating Scales-Preschool/Kindergarten Form (GRS-P): A Preliminary Examination of Their Psychometric Properties in Two Greek Samples. Diagnostics, 12(11), 2809. https://doi.org/10.3390/diagnostics12112809

Sternberg, R. J. (1985). Implicit Theories of Intelligence, Creativity, and Wisdom. Journal of Personality and Social Psychology, 49(3), 607. https://doi.org/10.1037/0022-3514.49.3.607

Sternberg, R. J. (2000a). Giftedness as Developing Expertise. In K. A. Heller, F. J. Mönks, R. J. Sternberg, & R. F. Subotnik (Eds.), International Handbook of Giftedness and Talent, (2nd. Ed., pp. 55-66). Elsevier. https://doi.org/10.1016/B978-008043796-5/50004-8

Sternberg, R. J. (2000b). Identifying and Developing Creative Giftedness. Roeper Review, 23(2), 60-64. https://doi.org/10.1080/02783190009554067

Sternberg, R. J., & Kaufman, S. B. (2018). Theories and Conceptions of Giftedness. In S.I. Pfeiffer (Ed.), Handbook of Giftedness in Children (2nd. Ed., pp. 29-47). Springer. https://doi.org/10.1007/978-3-319-77004-8_3

Subotnik, R. F., Olszewski-Kubilius, P., & Worrell, F. C. (Eds.). (2019). The Psychology of High Performance: Developing Human Potential Into Domain-Specific Talent. American Psychological Association. https://doi.org/10.1037/0000120-000

Tourón, J. (2023). ¿Puede una escuela inclusiva ignorar a sus estudiantes con altas capacidades? Entera2.0., 10, 24-46. https://ciberespiral.org/es/entera2-0-numero-10/

Tourón, J., Martín, D., Navarro Asensio, E., Pradas, S. e Íñigo, V. (2018). Validación de constructo de un instrumento para medir la competencia digital docente de los profesores (CDD) [Construct validation of a questionnaire to measure teachers’ digital competence (TDC)]. Revista Española de Pedagogía, 76(269), 2554. https://doi.org/10.22550/REP76-1-2018-02

Tourón, M., Navarro-Asencio, E. & Tourón, J. (2023a). Validez de Constructo de la Escala de Detección de Alumnos con Altas Capacidades para Padres (GRS2), en España. Revista de Educación. . (402), 53–80. https://doi.org/10.4438/1988-592X-RE-2023-402-595

Tourón, M.; Tourón, J.; Navarro-Asencio, E. (2023b). Validación española de la Escala de Detección de altas capacidades, Gifted Rating Scales 2 (GRS 2-S) School Form, para profesores. [Spanish Validation of the Gifted Rating Scales (GRS 2-S) School Form]. Estudios sobre Educación, 46. pre-print.

Viladrich, C., Angulo-Brunet, A., & Doval, E. (2017). A Journey Around Alpha and Omega to Estimate Internal Consistency Reliability. Annals of Psychology, 33(3), 755-782. https://doi.org/10.6018/analesps.33.3.268401

Winner, E. & Martino, G. (2000). Giftedness in Non- Academic Domains: The Case of the Visual Arts and Music. In K.A. Heller, F.J. Monks, R.J. Sternberg, & R.F. Subotnik (Eds.), International Handbook of Giftedness and Talent, (2nd. Ed., pp. 95–110). Elsevier. https://doi.org/10.1016/B978-008043796-5/50007-3

Xia, Y. (2016). Investigating the Chi-square Based Model-fit Indexes for WLSMV and ULSMV Estimators (Dissertation). Florida State University. http://purl.flvc.org/fsu/fd/FSU_2016SU_Xia_fsu_0071E_13379

Notas de autor

Enlace alternativo

https://revistaseug.ugr.es/index.php/RELIEVE/article/view/27787 (html)