Artículos

Validación de una herramienta para medir la Competencia Digital Docente del profesorado de educación Secundaria en formación inicial

Validation of a tool to measure the digital competence of secondary school teachers in initial teacher training

Validação de uma ferramenta para medir a Competência Digital Docente dos professores do ensino secundário em formação inicial

对测验处在培养初期的未来中等教育阶段教师数字化能力的工具进行验证

التحقق من صحة أداة لقياس كفاءة التدريس الرقمي لمعلمي التعليم الثانوي في التدريب الأولي

Validación de una herramienta para medir la Competencia Digital Docente del profesorado de educación Secundaria en formación inicial

RELIEVE. Revista Electrónica de Investigación y Evaluación Educativa, vol. 29, núm. 2, 2023

Universidad de Granada

Esta obra está bajo una Licencia Creative Commons Atribución-NoComercial 4.0 Internacional.

Recepción: 08 Julio 2022

Aprobación: 01 Mayo 2023

Publicación: 11 Diciembre 2023

Financiamiento

Nº de contrato: 2020 ARMIF 00006.

Beneficiario: Ramon Palau, Universitat Rovira i Virgili

Fuente: Proyecto "CERTICDOCENT: Certificació de la Competència Digital Docent del professorat d’educació secundària en formació inicial", Ajuts de recerca per a la millora de la formació inicial de mestres i professorat de secundària, AGAUR.

Resumen: En el contexto educativo actual, el uso de las Tecnologías de la Información y la Comunicación (TIC) después de la pandemia todavía ha tomado mayor importancia. Cada vez existe más conciencia de la necesidad de fomentar la adquisición de la Competencia Digital Docente (CDD) y así mismo de su evaluación. La CDD se ha intentado medir y evaluar con diferentes técnicas e instrumentos, pero todavía no existe una herramienta específica para medirla en docentes de educación secundaria en formación inicial. El objetivo de este trabajo es validar un instrumento para evaluar de forma objetiva los conocimientos de la CDD de los futuros docentes de educación secundaria. Así, en este trabajo se adapta y valida la existente herramienta COMDID-C, utilizada con futuros maestros y maestras. En una primera fase se realizó la adaptación del instrumento al contexto de educación secundaria, con la participación de 21 expertos en la materia. En una segunda fase piloto, 667 docentes de educación secundaria en formación respondieron la prueba. Aunque el análisis de fiabilidad arrojó resultados del alfa ordinal que indican que los factores no tienen buena consistencia interna, se puede explicar debido a que el análisis se realizó a partir de pares de preguntas aleatorizadas, no pudiéndose establecer ningún otro sistema de equivalencias para su análisis. En cualquier caso, y teniendo en cuenta la consistencia interna, se puede constatar que el instrumento mantiene una estructura equiparable al instrumento predecesor. Esta herramienta permitirá conocer la CDD de los futuros docentes, al mismo tiempo permitirá reflexionar sobre el nivel, tanto de partida o salida, de la formación de estos, y a partir de estos datos diseñar y adecuar los planes de formación para una mejor adquisición de esta competencia.

Palabras clave: Competencia digital docente, Validación de cuestionario, Enseñanza secundaria, Docencia, Formación de docentes de secundaria.

Abstract: Education has become even more dependent on information and communication technologies (ICT) in today’s post-pandemic era, and there is a growing awareness of the need to promote and assess teachers’ digital competence. Different techniques and tools have been used to try to measure and assess digital competence, but there is still no specific tool that can measure it among secondary school teachers completing their initial training. The aim of this paper is to validate a tool that is able to objectively assess the digital competence and knowledge of future secondary school teachers. In this paper, therefore, we adapt and validate the existing tool known as COMDID-C, currently used for future primary school teachers. In the first phase, 21 experts in the field worked on adapting the tool to suit secondary education. In a second pilot phase, 667 trainee secondary school teachers completed the test. The reliability analysis yielded ordinal alpha results indicating that the factors are not wholly internally consistent. However, this may be attributed to the fact that the analysis was carried out on the basis of randomised pairs of questions, without the possibility of establishing any other system of equivalence. In any case, bearing in mind the internal consistency, it is clear that the tool’s structure is comparable to that of its predecessor. This tool will make it possible to ascertain future teachers’ digital competence and reflect on their level of training at the start and at the end. It will also mean we can use this data to design and adapt training plans that improve the acquisition of these digital skills.

Keywords: Digital competence, Questionnaire validation, Secondary education, Teaching, Secondary school teacher training.

Resumo: No atual contexto educativo, a utilização das tecnologias da informação e da comunicação (TIC) após a pandemia tornou-se ainda mais importante. Existe uma consciência crescente da necessidade de fomentar a aquisição da Competência Digital Docente (CDD) e também a sua avaliação. Foram feitas tentativas para medir e avaliar a CDD com diferentes técnicas e instrumentos, mas ainda não existe uma ferramenta específica para a medir em professores do ensino secundário em formação inicial. O objetivo deste trabalho é validar um instrumento para avaliar objetivamente os conhecimentos da CDD dos futuros professores do ensino secundário. Assim, neste trabalho, adapta-se e valida-se a ferramenta COMDID-C existente, utilizada com futuros professores. Numa primeira fase, o instrumento foi adaptado ao contexto do ensino secundário, com a participação de 21 peritos na matéria. Numa segunda fase piloto, 667 professores de ensino secundário em formação fizeram o teste. Embora a análise de fiabilidade tenha produzido resultados do alfa ordinal que indicam que os fatores não têm uma boa consistência interna, tal pode ser explicado pelo facto de a análise ter sido realizada com base em pares de perguntas aleatórias, não tendo sido possível estabelecer qualquer outro sistema de equivalência para a sua análise. Em todo o caso, e tendo em conta a consistência interna, pode-se constatar que o instrumento mantém uma estrutura comparável à do instrumento antecessor. Esta ferramenta permitirá conhecer a CDD dos futuros professores e, ao mesmo tempo, permitirá refletir sobre o nível, tanto de partida como de saída, da sua formação e, com base nestes dados, conceber e adequar os planos de formação para uma melhor aquisição desta competência.

Palavras-chave: Competência digital docente, Validação de questionário, Ensino secundário, Docência, Formação de professores do ensino secundário.

摘要: 在现在的教育环境下,即使是在疫情结束后,信息通讯技术的使用仍然承担着重要的作用。与此同时,教师数字化能力的获取及评估意识也在日益加强。现已有测量和评估教师数字化能力的工具众多,可针对处在培养初期的未来中等教育教师数字化能力的测量工具却一个也没有。所以该研究的主要目的是验证一项对未来中等教育教师的数字化能力进行客观评估的工具。研究对已存在的COMDID-C工具进行调整和验证,来对未来教师的数字化能力进行测量。在研究的第一阶段,根据中等教育背景,由21名专家参与对工具进行调整。在研究的第二拓展阶段,667名仍处在学习阶段的未来中学教师参与了实验。研究信度分析中的定序变量结果显示因素间缺少内部一致性,导致该结果的原因很明确,就是分析样本由随机性问题组成,无法建立对等系统进行分析,但即便如此,通过内部一致性,也可以证实研究使用的调整工具与原工具保持结构一致性。这项工具不但让我们对未来教师数字化能力得到了解,还同时允许我们对这些未来教师在培养初期及培养结束时的水平进行反思。因此,研究可以在这些数据的基础上,调整设计出能够更好地提高教师数字化能力的培养计划。

關鍵詞: 教师的数字化能力, 问卷验证, 中等教育, 教师, 中等教育阶段的教师培养.

ملخص: في السياق التعليمي الحالي, أصبح استخدام تكنولوجيا المعلومات والاتصالات (TIC) بعد الوباء أكثر أهمية. هناك وعي متزايد بالحاجة إلى تعزيز اكتساب كفاءة التدريس الرقمي (CDD) وتقييمها. وقد بذلت محاولات لقياس وتقييم التنمية المجتمعية باستخدام تقنيات وأدوات مختلفة, ولكن لا توجد حتى الآن أداة محددة لقياسها لدى معلمي التعليم الثانوي في التدريب الأولي. الهدف من هذا العمل هو التحقق من صحة أداة لتقييم موضوعي معرفة CDD لمعلمي التعليم الثانوي في المستقبل. وبالتالي, في هذا العمل, تم تكييف أداة COMDID-C الحالية, المستخدمة, مع معلمي المستقبل, والتحقق من صحتها. وفي المرحلة الأولى, تم تكييف الأداة مع سياق التعليم الثانوي, بمشاركة 21 خبيرا في هذا المجال. وفي المرحلة التجريبية الثانية, أجاب على الاختبار 667 معلماً في التعليم الثانوي قيد التدريب. على الرغم من أن تحليل الموثوقية أظهر نتائج ألفا الترتيبية التي تشير إلى أن العوامل ليس لديها اتساق داخلي جيد, إلا أنه يمكن تفسير ذلك لأن التحليل تم إجراؤه باستخدام أزواج من الأسئلة العشوائية, ولم يكن من الممكن إنشاء نظام آخر للتكافؤلتحليلك.على أية حال, ومع الأخذ في الاعتبار الاتساق الداخلي, يمكن ملاحظة أن الأداة تحافظ على هيكل مماثل للأداة السابقة. ستسمح لنا هذه الأداة بمعرفة مهارات التطوير المهني لمعلمي المستقبل, وفي الوقت نفسه ستسمح لنا بالتفكير في مستوى تدريبهم, سواء في البداية أو الخروج, وبناء على هذه البيانات، تصميم

الكلمات المفتاحية: تدريس الكفاءة الرقمية, التحقق من صحة الاستبيان, التعليم الثانوي, التدريس, تدريب المعلمين الثانوي.

Introducción

La Competencia Digital Docente (CDD), o competencia digital que deben demostrar los y las docentes, toma cada vez más importancia en el contexto educativo actual (Palau & Mogas, 2022a; 2022b). Es por este motivo que se hace necesario crear instrumentos que permitan medir la CDD de diferentes perfiles docentes y ello contribuya a abordar la capacitación de la comunidad educativa (Palau et al., 2019; Palau et al., 2021).

La pandemia, inesperada e inmediata (Sangrà, 2020) ha marcado un punto de no retorno, que debe proporcionar una oportunidad para impulsar la digitalización de los sistemas educativos (Comisión Europea, 2021). La OCDE (2021) describe las tecnologías digitales como capaces de dar nuevas respuestas a las nuevas necesidades de un aprendizaje más personalizado y autónomo, y la Comisión Europea (2021) lanza una nueva estrategia sobre la educación digital. La propia OCDE (2022) nos invita a repensar cómo será el futuro de la educación en 15 o 20 años, y aprovechar las innovaciones surgidas durante la pandemia para, entre otros fines, capacitar a los y las docentes para que sean más autónomos, participen activamente en el diseño de entornos de aprendizaje y tengan conocimientos y dinamismo en el uso de la tecnología (Schleicher, 2022).

La competencia digital se establece como fundamental para responder a los retos que plantea la digitalización, y la educación se considera la clave para promover su desarrollo (Ilomäki et al., 2016). La competencia digital se ha convertido en uno de los principales focos de atención de las políticas educativas como consecuencia de una sociedad y un lugar de trabajo impulsados por la tecnología (Lucas et al., 2021). Preparar a los y las futuras docentes en su CDD es una necesidad para hacerles competentes en el contexto de los centros educativos actuales, cada vez más digitalizados (Starkey, 2020).

Queda claro, pues, que en tiempos de post pandemia uno de los aprendizajes del sector educativo es en relación con la necesidad de formación y desarrollo de la CDD (Palau et al., 2021), de acuerdo con la inclusión de la competencia digital dentro de los Objetivos de Desarrollo (ONU, 2015). El profesorado necesita ser capaz de utilizar las tecnologías digitales con una pedagogía bien fundamentada para mejorar el aprendizaje del alumnado y facilitar su competencia digital (Redecker & Punie, 2017), ya que un uso básico de las tecnologías de la información y la comunicación (TIC) no significa un ejercicio profesional competente. Esto apuntala la importancia de añadir el criterio pedagógico y contextual (Krumsvik, 2008; 2014). Los diseños de aprendizaje deben revisarse continuamente debido a que las tecnologías en el contexto escolar cambian de forma continua y a gran velocidad (Starkey, 2020).

Es necesario que el profesorado de educación secundaria tenga la suficiente experiencia técnica y habilidades para trabajar y enseñar usando las TIC, así como para ayudar al alumnado a desarrollar las competencias tecnológicas adecuadas (Pérez-Navío et al., 2021). Castañeda et al. (2018) remarcan la necesidad de tener en consideración que la CDD se debe empezar a desarrollar en la formación inicial del profesorado.

La CDD se ha concretado en diferentes marcos que se han ido presentando en los últimos 15 años. Entre estos marcos cabe destacar Enlaces (2008; 2011) del Ministerio de Educación de Chile, NETS-T de la Sociedad Internacional de Tecnología en Educación (ISTE, 2008), los estándares de competencia TIC de la UNESCO (2008; 2019), DigiLit de Fraser et al. (2013), los diferentes marcos desarrollados por el Instituto Nacional de Tecnologías Educativas y de Formación del Profesorado (INTEF, 2014; 2017; 2022), el marco de referencia de ARGET publicado por Lázaro y Gisbert (2015), el de la Generalitat de Catalunya (2016) o el DigComp de Redecker y Punie (2017) para la Comisión Europea. Este último se puede considerar el más popular y centrado en la mejora de la comprensión y el desarrollo de la competencia digital (Ferrari, 2013). La Comisión Europea (2018a) estableció un consenso entre los países europeos sobre las competencias digitales, con la idea de que un marco compartido envíe un mensaje claro sobre su importancia.

Del desarrollo de la CDD se ha evidenciado la necesidad de evaluación de esta para tomar conciencia del nivel de CDD y que se tenga en cuenta en la planificación, enseñanza y evaluación de las actividades de formación (Tejada & Ruiz, 2016). Al mismo tiempo, la CDD debe estar orientada al aprendizaje, en el que la retroalimentación proporcionada juega un papel fundamental (Cosi et al., 2020). Es necesario señalar que, según Revuelta-Domínguez et al. (2022), este gran interés tiene su máximo exponente en la comunidad científica española, donde se han publicado gran número de artículos sobre la evaluación del nivel de competencia digital de docentes en activo y en formación inicial.

En este sentido, la inclusión de procesos de autoevaluación dentro de la evaluación formativa en la formación inicial del profesorado es clave para ayudar a los futuros docentes a tomar conciencia de su propio nivel de desarrollo en esta competencia (Cosi et al., 2020). Centrados en esta formación inicial de docentes, Lázaro y Gisbert (2015) y la Generalitat de Cataluña (2018) señalan que el primer nivel de desarrollo de la CDD es el nivel que los docentes en formación y noveles deben adquirir al finalizar su formación inicial.

Actualmente, las formas de medición de la CDD parten de dimensiones, descriptores e indicadores de los marcos anteriormente citados. En los últimos años, se han desarrollado diversos estudios y pruebas de evaluación de la CDD que permiten analizar su nivel en docentes y docentes en formación inicial (Cai et al., 2017). Algunas de estas pruebas son el Wayfind Teacher Assessment (Banister & Reinhart, 2012), que hace una autoevaluación del uso de la tecnología por parte de los docentes. El de Viberg (2018), basado en la Theory of Acceptance and Use of Technology (TAM). SELFIE, uno de los más conocidos, sustentado en la autopercepción, a partir del marco DigCompEdu de la Comisión Europea (Redecker & Punie, 2017; Comisión Europea, 2018b) como estándar de referencia. Por su parte, Tourón et al. (2018) desarrollaron un cuestionario también en función del autoreporte, como el COMDID-A (Lázaro & Gisbert, 2015) o el ACDC (Andía-Celaya et al., 2020).

En lo que hace referencia a la evaluación de la CDD de los docentes de educación secundaria, se observan menos trabajos que de su respectiva para maestros de educación primaria. Sobre los estudios realizados en docentes de educación secundaria destacamos el de Prieto-Ballester et al. (2021), el de Jiménez-Hernández et al. (2020), o el de Portillo et al. (2020) que mezcla docentes de varias etapas educativas, todos ellos basados en la autopercepción. Aunque existen herramientas como las anteriormente mencionadas, se evidencia la necesidad de desarrollar algún instrumento válido que permita evaluar el desarrollo de la CDD y que esté sustentado no solamente en la autopercepción (Palau et al., 2019).

En este artículo se expone el trabajo realizado para abordar el objetivo de validar un instrumento que permita evaluar de forma objetiva los conocimientos de la CDD de los futuros docentes de educación secundaria a partir de la adaptación de la herramienta COMDID-C en su versión para maestros de educación primaria. El motivo de proponer esta actualización radica en que las preguntas del COMDID-C para maestros y maestras están orientadas en aspectos propios de la educación primaria; se reconoce necesario proponer un instrumento objetivo con preguntas redactadas para ser contestadas por docentes de educación secundaria en formación.

A partir de esta necesidad identificada y guiados por el objetivo expuesto, a continuación, se detalla el método seguido, se presentan los resultados obtenidos, y finalmente se discuten los resultados para terminar trazando unas conclusiones.

Método

Con base en la construcción del instrumento COMDID-C para la medición la competencia digital docente del futuro profesorado (Lázaro et al., 2019), y apoyado en la revisión de la literatura, el estudio se realizó siguiendo un procedimiento de dos fases: el COMDID-C fue adaptado y posteriormente validado para la evaluación de la competencia digital docente por parte de futuros docentes de secundaria. En un primer lugar, se adaptó siguiendo un juicio de expertos mediante un método cualitativo. En segundo lugar, la herramienta se aplicó en modalidad online en una fase piloto con estudiantes del Máster oficial en Formación del Profesorado de Educación Secundaria Obligatoria y Bachillerato, Formación Profesional y Enseñanza de Idiomas (MUFP) de las once universidades públicas catalanas que ofertan estos estudios. A partir de los datos obtenidos se realizaron los estudios de validación de constructo y fiabilidad de la herramienta.

La investigación se llevó a cabo respetando estándares éticos. Se informó de la investigación y se solicitó la aceptación expresa de los participantes para contestar el cuestionario a través de un consentimiento informado, respetando la autonomía de su voluntad. Se acordó la autorización para realizar este estudio a las Coordinaciones del MUPF de cada una de las universidades participantes. Los datos de las personas participantes fueron anonimizados y almacenados en una base de datos en el sistema informático de la Univesitat Rovira i Virgili, con acceso restringido a una parte del equipo de investigación.

Muestra

El estudio se enmarca en el Máster de Formación del Profesorado (MUFP), por lo que todos los participantes eran docentes e investigadores o estudiantes de alguna de las once universidades participantes. De esta manera, la técnica de muestreo utilizada fue no probabilística por conveniencia.

Las universidades participantes son: Universitat Rovira i Virgili (URV), Universitat de Barcelona (UB), Universitat Autònoma de Barcelona (UAB), Universitat Oberta de Catalunya (UOC), Universitat Politècnica de Catalunya (UPC), Universitat Politècnica de Catalunya (UPC), Universitat Pompeu Fabra (UPF), Universitat de Lleida (UdL), Universitat Ramon Llull (URL), Universitat de Girona (UdG), e Interuniversitari de Matemàtiques (UPC-UOC).

El trabajo se ha desarrollado siguiendo las dos fases introducidas, y en las cuales se ha contado con la siguiente participación:

Fase 1: Para estudiar la validez de contenido de la nueva herramienta colaboraron en su adaptación 21 profesionales (mujeres, n=10 y, hombres, n=11). Por un lado, 14 investigadores y docentes que trabajan en la universidad, concretamente los coordinadores de este máster en cada institución académica, realizaron la adaptación y validación inicial. Todos ellos acreditaron poseer conocimientos avanzados en formación inicial del profesorado y en formación en competencias digitales docentes. De estos, 6 participaron en la adaptación de la herramienta anterior a las necesidades del contexto de las escuelas secundarias (n=6) mientras que 8 revisaron en profundidad los cambios y toda la nueva propuesta para aconsejar qué mejorar. Por otro lado, 7 directores de centros de educación secundaria y expertos en formación inicial docente y en formación de competencias digitales docentes también revisaron la herramienta propuesta con el objetivo de verificar la conveniencia de las preguntas y respuestas escritas (es decir, validación de la adaptación realizada por n=15 expertos). Estas interacciones se organizaron de forma anónima a través de Microsoft Forms. Los responsables de la adaptación recibieron los informes y completaron la fase aplicando los cambios sugeridos en la adaptación.

Fase 2: Para estudiar la validez de constructo y medir la fiabilidad de esta versión, el cuestionario fue respondido por estudiantes del MUFP. La muestra estuvo compuesta por 667 estudiantes, de los cuales 197 no respondieron el cuestionario completo y fueron considerados no elegibles. Así, la muestra efectiva fue n=470. La edad media fue de 31.16 años, la mediana de 28 y la moda de 24, oscilando los y las participantes entre los 22 y los 59 años. Las edades mayores de cincuenta y cuatro años se identificaron como valores atípicos. En cuanto al género, 263 eran mujeres (56%), 197 hombres (42%) y otros 10 (2%).

Diseño de la herramienta

Igual que en las otras versiones del cuestionario COMDID, este está dividido en las cuatro dimensiones de la CDD: D1 “Aspectos didácticos, curriculares y metodológicos”, D2 “Planificación, organización y gestión de recursos y espacios tecnológicos digitales”, D3 “Aspectos relacionales, ética y seguridad”, y D4 “Aspectos personales y profesionales”. Los criterios para su adaptación a los docentes de secundaria fueron: 1) Adaptar las preguntas y respuestas a los escenarios de los centros de educación secundaria, repensando las situaciones o ajustándolas a la realidad de secundaria. Una instrucción principal fue la de seguir el mismo estilo de enunciados, pero sin cambios sustanciales para evitar hacer un cuestionario completamente diferente. 2) El nuevo cuestionario es una herramienta de evaluación para la formación inicial y no para docentes en activo. 3) En las versiones anteriores de COMDID-C una misma pregunta podía tener varias opciones correctas calificadas (es decir, una respuesta marcada como 100% correcta, otra marcada como 75%, otra 50% y la última 0%). En la adaptación de la herramienta, y siguiendo recomendaciones de experiencias anteriores, se decidió que este cuestionario debía tener siempre una sola respuesta correcta y tres distractores.

Un ejemplo que evidencia la necesidad de replantear la redacción de las preguntas sería:

En una situación de aula con alumnos de Educación Primaria, entre 10 y 12 años, quieres potenciar su participación durante la presentación de un contenido teórico. La actividad debe servir como evaluación inicial, para averiguar qué conocimientos previos tienen sobre un tema a trabajar. ¿Cuál de esos recursos digitales crees que resulta más adecuado? [seguido de cuatro opciones de respuesta].

En este caso concreto se pudieron respetar las opciones de respuesta propuestas, pero se reenfocó “con alumnos de Educación Primaria, entre 10 y 12 años” hacia “alumnado de Educación Secundaria”.

Las preguntas se plantean como una situación a resolver por parte del docente, evitando lo máximo posible la autopercepción sobre su propio desempeño. A modo de ejemplo, una pregunta que se formula en la D1 es: “Para proponer una actividad que se desarrolle de una forma colaborativa y en línea, ¿qué recurso digital consideras más adecuado? Las opciones de respuesta posible son: a. Vídeos educativos (Youtube, Khan Academy, ...); b. Aplicaciones 2.0 (Blog, Wiki, Google Docs, ...).; c. Aplicaciones de escritorio (Word, Power Point, Photoshop, ...); d. Ninguna de las anteriores es correcta.

El cuestionario COMDID-C original constaba de 88 preguntas para evaluar la competencia digital docente. En versiones anteriores de esta herramienta los investigadores indicaron cierta dificultad para ser respondida debido a su extensión. Además, el estudio de validez de Lázaro et al. (2019) asegura que dividir el instrumento en dos de 44 preguntas es igualmente válido. Por esta razón, el cuestionario para futuros profesores y profesoras de secundaria se diseñó de la misma manera (es decir, con 88 preguntas), pero se presentó a cada estudiante solo una pregunta para cada par de preguntas correspondiente a un mismo descriptor (mediante la utilidad de la herramienta tecnológica en la que se implementó la prueba, Alchemer). Esto significa que, de manera aleatoria, cada estudiante recibió solo una pregunta del par 1-2, una pregunta del par 3-4 y así sucesivamente.

Además de las directrices principales, los validadores solo sugirieron algunos cambios relacionados con errores gramaticales, la redacción confusa de algunas preguntas o ejemplos obsoletos en las respuestas propuestas (por ejemplo, nombrar una herramienta digital que ya no está disponible).

A los expertos que validaron la herramienta se les pidió que calificasen para cada pregunta su comprensión, relevancia e importancia en una escala Likert de 1 a 4. Los tres indicadores aparecieron calificados con valoraciones altas en la mayoría de los ítems, y en ningún caso como para omitir o reformular completamente alguna de las preguntas. En varios casos los expertos informaron que algunas preguntas eran demasiado obvias y fáciles, pero en la versión final se mantuvieron por respetar la coherencia con los cuestionarios anteriores y en espera del análisis estadístico con resultados específicos para la validación de esta adaptación.

Análisis de datos

El análisis de los datos se llevó a cabo con los softwares SPSS 27.0, JASP 0.16.3 y Excel, dependiendo de las pruebas. Se realizaron tanto el Análisis Factorial Confirmatorio (AFC) como las pruebas de fiabilidad, de calidad y de dificultad del cuestionario. Para el AFC se definieron cuatro factores en base a las cuatro dimensiones ya formuladas en el COMDID-A. No se realizó rotación factorial.

Resultados

Antes de proceder a realizar el análisis factorial, se evaluó si los datos eran apropiados para llevarlo a cabo. Se aplicó la medida de adecuación muestral KMO (Kaiser-Meyer-Olkin) que arrojó un resultado de KMO=0.910 y la prueba de esfericidad de Bartlett (χ2=4118.598, gl=946, p=.000). Los resultados indicaron que se podía proceder a la factorización, ya que un KMO mayor que 0.80 lo permite (Kaiser, 1970) así como los altos valores de la prueba de Bartlett. De esta manera se realizó un Análisis Factorial Confirmatorio (AFC) para corroborar las cuatro dimensiones de la versión anterior del cuestionario COMDID-C destinado a maestros. A continuación, se presenta la matriz de cargas factoriales obtenida (Tabla 1).

| 95% Consistencia Int. | ||||||||

| Factor | Indicador | Símbolo | Estimado | Std. Error | Valor-z | p | Más bajo | Más alto |

| Factor 1 (D1) | 1-2 | λ11 | 0.173 | 0.018 | 9.586 | < .001 | 0.137 | 0.208 |

| 3-4 | λ12 | 0.299 | 0.020 | 15.260 | < .001 | 0.261 | 0.338 | |

| 5-6 | λ13 | 0.295 | 0.021 | 14.245 | < .001 | 0.255 | 0.336 | |

| 7-8 | λ14 | 0.268 | 0.022 | 12.434 | < .001 | 0.226 | 0.310 | |

| 9-10 | λ15 | 0.194 | 0.023 | 8.327 | < .001 | 0.149 | 0.240 | |

| 11-12 | λ16 | 0.197 | 0.023 | 8.496 | < .001 | 0.151 | 0.242 | |

| 12-13 | λ17 | 0.311 | 0.020 | 15.875 | < .001 | 0.272 | 0.349 | |

| 15-16 | λ18 | 0.139 | 0.023 | 6.059 | < .001 | 0.094 | 0.185 | |

| 17-18 | λ19 | 0.170 | 0.022 | 7.581 | < .001 | 0.126 | 0.214 | |

| 19-20 | λ110 | -0.032 | 0.024 | -1.312 | 0.189 | -0.080 | 0.016 | |

| 21-22 | λ111 | 0.295 | 0.021 | 14.148 | < .001 | 0.254 | 0.336 | |

| 23-24 | λ112 | 0.125 | 0.020 | 6.140 | < .001 | 0.085 | 0.164 | |

| Factor 2 (D2) | 25-26 | λ21 | 0.318 | 0.019 | 16.892 | < .001 | 0.281 | 0.355 |

| 27-28 | λ22 | 0.306 | 0.021 | 14.733 | < .001 | 0.266 | 0.347 | |

| 29-30 | λ23 | 0.015 | 0.019 | 0.803 | 0.422 | -0.022 | 0.052 | |

| 31-32 | λ24 | 0.228 | 0.014 | 16.039 | < .001 | 0.200 | 0.256 | |

| 33-34 | λ25 | -0.004 | 0.021 | -0.181 | 0.857 | -0.045 | 0.037 | |

| 35-36 | λ26 | 0.157 | 0.020 | 7.977 | < .001 | 0.118 | 0.195 | |

| 37-38 | λ27 | 0.288 | 0.015 | 19.611 | < .001 | 0.259 | 0.317 | |

| 39-40 | λ28 | 0.190 | 0.016 | 11.848 | < .001 | 0.159 | 0.222 | |

| 41-42 | λ29 | 0.016 | 0.021 | 0.797 | 0.426 | -0.024 | 0.057 | |

| 43-44 | λ210 | 0.191 | 0.022 | 8.812 | < .001 | 0.148 | 0.233 | |

| Factor 3 (D3) | 45-46 | λ31 | 0.048 | 0.023 | 2.087 | 0.037 | 0.003 | 0.094 |

| 47-48 | λ32 | 0.065 | 0.021 | 3.123 | 0.002 | 0.024 | 0.106 | |

| 49-50 | λ33 | 0.315 | 0.023 | 13.762 | < .001 | 0.270 | 0.359 | |

| 51-52 | λ34 | 0.102 | 0.025 | 4.126 | < .001 | 0.054 | 0.151 | |

| 53-54 | λ35 | 0.118 | 0.023 | 5.062 | < .001 | 0.072 | 0.164 | |

| 55-56 | λ36 | 0.071 | 0.025 | 2.917 | 0.004 | 0.023 | 0.120 | |

| 57-58 | λ37 | 0.027 | 0.023 | 1.179 | 0.239 | -0.018 | 0.073 | |

| 59-60 | λ38 | -0.072 | 0.025 | -2.950 | 0.003 | -0120 | -0.024 | |

| 61-62 | λ39 | 0.116 | 0.023 | 5.117 | < .001 | 0.072 | 0.160 | |

| 63-64 | λ310 | 0.055 | 0.019 | 2.883 | 0.004 | 0.018 | 0.093 | |

| Factor 4 (D4) | 65-66 | λ41 | 0.120 | 0.022 | 5.455 | < .001 | 0.077 | 0.163 |

| 67-68 | λ42 | 0.135 | 0.021 | 6.291 | < .001 | 0.093 | 0.177 | |

| 69-70 | λ43 | -0.027 | 0.025 | -1.089 | 0.276 | -0.076 | 0.022 | |

| 71-72 | λ44 | 0.302 | 0.020 | 14.829 | < .001 | 0.262 | 0.342 | |

| 73-74 | λ45 | 0.109 | 0.020 | 5.547 | < .001 | 0.070 | 0.147 | |

| 75-76 | λ46 | 0.154 | 0.019 | 8.136 | < .001 | 0.117 | 0.191 | |

| 77-78 | λ47 | 0.069 | 0.017 | 3.949 | < .001 | 0.035 | 0.103 | |

| 79-80 | λ48 | 0.265 | 0.020 | 12.963 | < .001 | 0.225 | 0.305 | |

| 81-82 | λ49 | -0.137 | 0.024 | -5.579 | < .001 | -0.185 | -0.089 | |

| 83-84 | λ410 | 0.263 | 0.021 | 12.672 | < .001 | 0.222 | 0.304 | |

| 85-86 | λ411 | 0.022 | 0.025 | 0.895 | 0.371 | -0.027 | 0.071 | |

| 87-88 | λ412 | 0.264 | 0.023 | 11.398 | < .001 | 0.219 | 0310 | |

Con relación al ajuste del modelo, el valor de χ2/d.f. fue de 4269.111/946 (p<.001), habiendo discrepancia significativa entre las variables esperadas y observadas. Este valor se considera aceptable (Hooper et al., 2008).

| Model | Χ² | df | P |

| Baseline model | 4269.111 | 946 | |

| Factor model | 1050.024 | 896 | < .001 |

Respecto a otros parámetros de bondad de ajuste del modelo relevantes para el estudio, se obtuvieron buenos resultados. El Goodness of Fit Index (GFI) fue de 0.908, del cual generalmente se considera 0.90 el mínimo aceptable (Hooper et al., 2008), el Root Mean Square Error of Approximation (RMSEA) y el Standardized Root Mean Residual (SRMR) se consideran aceptables con valores menores a 0.6 e inferiores a 0.08 respectivamente (Fan & Sivo, 2007; McDonald & Ho, 2002). En el caso el resultado en nuestro modelo es RMSEA=0.019 (IC=0.014 y 0.024) y SRMR=0.04, por lo que indica buen ajuste.

Para conocer la consistencia interna de cada una de las cuatro dimensiones se aplicó el coeficiente alfa ordinal, como la alternativa más adecuada cuando no se cumplen los requisitos para aplicar el popular alfa de Cronbach, en este caso, debido a que las variables del estudio son de naturaleza ordinal y no continuas (Elosua & Zumbo, 2008) y debería haber como mínimo 5 categorías de respuesta (Domínguez-Lara, 2018). Para el cálculo de alfa ordinal se utilizó el módulo de Excel diseñado por Domínguez-Lara (2018). En la dimensión D1 “Didáctica, curricular y metodológica”, el resultado fue de α=0.359, en la dimensión D2 “Planificación, organización y gestión de espacios y recursos tecnológicos digitales” fue α=0.243, en la dimensión D3 “Relacional y ética” fue de α=0.065, y en la dimensión D4 “Personal y profesional” α=0.183. El coeficiente alfa ordinal se interpreta de la misma manera que alfa, por lo que estos resultados apuntarían a una consistencia interna baja, lo que requiere una revisión de los ítems, como se trata a continuación.

La calidad de los ítems se calculó para cada una de las dimensiones mediante el coeficiente de correlación biserial, el cual determina el grado en que las competencias que mide el instrumento también las mide el reactivo (Backhoff et al., 2000). Ebel y Frisbie (1986), citado en Backhoff et al. (2000), muestran los valores para determinar la calidad de los reactivos, en términos del índice de discriminación: > 0.39 excelente, 0.30 - 0.39 buena, 0.20 - 0.29 regular, 0.00 - 0.20 pobre y < -0.01 pésima.

De acuerdo con estos criterios, en la D1 el par de ítems 19-20 no alcanzaría un estándar de calidad adecuado (Tabla 3).

| Items | Correlación biserial | SD |

| 1-2 | 0.394 | 0.392 |

| 3-4 | 0.521 | 0.457 |

| 5-6 | 0.514 | 0.477 |

| 7-8 | 0.463 | 0.485 |

| 9-10 | 0.308 | 0.501 |

| 11-12 | 0.365 | 0.497 |

| 12-13 | 0.561 | 0.461 |

| 15-16 | 0.259 | 0.484 |

| 17-18 | 0.295 | 0.479 |

| 19-20 | -0.041 | 0.501 |

| 21-22 | 0.536 | 0.480 |

| 23-24 | 0.241 | 0.427 |

Observamos en la D2 que los reactivos 29-30, 33-34 y 41-42 no serían adecuados.

| Items | Correlación biserial | SD |

| 25-26 | 0.551 | 0.452 |

| 27-28 | 0.487 | 0.483 |

| 29-30 | 0.068 | 0.391 |

| 31-32 | 0.531 | 0.339 |

| 33-34 | 0.010 | 0.432 |

| 35-36 | 0.303 | 0.421 |

| 37-38 | 0.592 | 0.369 |

| 39-40 | 0.414 | 0.361 |

| 41-42 | 0.081 | 0.424 |

| 43-44 | 0.344 | 0.468 |

En la D3, todos los reactivos excepto el par 49-50 muestran déficits de calidad.

| Items | Correlación biserial | SD | ||||

| 45-46 | 0.147 | 0.466 | ||||

| 47-48 | 0.088 | 0.420 | ||||

| 49-50 | 0.268 | 0.440 | ||||

| 51-52 | 0.125 | 0.500 | ||||

| 53-54 | 0.090 | 0.472 | ||||

| 55-56 | 0.091 | 0.494 | ||||

| 57-58 | -0.041 | 0.467 | ||||

| 59-60 | -0.077 | 0.495 | ||||

| 61-62 | 0.096 | 0.460 | ||||

| 63-64 | 0.138 | 0.387 | ||||

Por último, la D4 evidencia pares de ítems con menor calidad como 69-70, 77-78, 81-82 y 85-86.

| Items | Correlación biserial | SD | ||||

| 65-66 | 0.246 | 0.447 | ||||

| 67-68 | 0.254 | 0.441 | ||||

| 69-70 | 0.002 | 0.499 | ||||

| 71-72 | 0.411 | 0.461 | ||||

| 73-74 | 0.211 | 0.399 | ||||

| 75-76 | 0.260 | 0.396 | ||||

| 77-78 | 0.169 | 0.352 | ||||

| 79-80 | 0.394 | 0.450 | ||||

| 81-82 | -0.129 | 0.500 | ||||

| 83-84 | 0.362 | 0.456 | ||||

| 85-86 | 0.038 | 0.500 | ||||

| 87-88 | 0.404 | 0.501 | ||||

Respecto a la dificultad de los ítems, que se entiende como la proporción de personas que responden correctamente un reactivo de una prueba, calculamos el índice de dificultad (ID= aciertos / aciertos + errores) en función del porcentaje de aciertos y errores de la muestra. La dificultad media del test es de p=0.668 (SD=0.143), siendo la mínima de 0.19 y la máxima de 0.92. La moda y la mediana coinciden en 0.7. Por dimensiones, encontramos ID(D1)= 0.604, ID(D2)= 0.767, ID(D3)= 0.621, ID (D4)= 0.629.

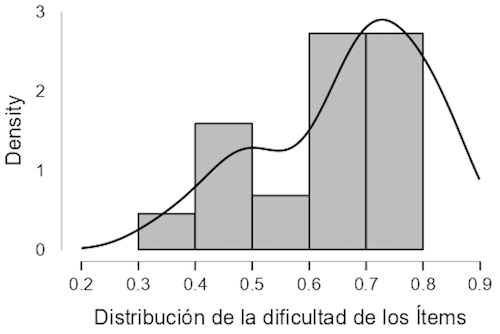

Como se aprecia en el gráfico, la variable de dificultad P no se distribuye normalmente, presenta asimetría negativa y un gran número de reactivos se agrupan alrededor 0.7. Esto significa que hay un mayor número de reactivos fáciles que difíciles.

Figura 1.

Distribución de la dificultad de los ítems

Según Backoff et al. (2000) se establecen diferentes niveles de dificultad: >0.86 = Altamente fáciles, 0.74 a 0.86 = Medianamente fáciles, 0.53 a 0.73 Dificultad media, 0.33 a 0.52 = Medianamente difíciles, <0.33 = Altamente difíciles. Como se observa en la tabla 7 la mayoría son de dificultad media (18 ítems, 41.04%) y medianamente fáciles (15 ítems, 34.2%), seguido de medianamente difíciles (10 ítems, 22.8%). En el extremo se encuentra un único ítem altamente difícil (2.28%), no habiendo ninguno altamente fácil.

Por último, para poder evaluar la CDD de la muestra, es necesario establecer el punto de corte, situado en el valor del 70%. De igual manera que se utilizó en el cuestionario que sirve de modelo a esta adaptación (Lázaro et al., 2019), se ha usado el método de Angoff (Mahias Finger & Polloni Erazo, 2019), el cual consiste en que expertos en la materia evaluada estiman la proporción de participantes que respondería correctamente o mínimamente aceptable a cada ítem de la prueba.

| Criterio | Interpretación | Ítems | P |

| < 0.32 | Altamente difíciles | 31-32 | 0.87 |

| 0.33 a 0.52 | Medianamente difíciles | 53-54 | 0.33 |

| 15-16 | 0.37 | ||

| 59-60 | 0.42 | ||

| 11-12 | 0.44 | ||

| 69-70 | 0.45 | ||

| 51-52 | 0.49 | ||

| 87-88 | 0.49 | ||

| 9-10 | 0.5 | ||

| 19-20 | 0.5 | ||

| 85-86 | 0.52 | ||

| 0.53 a 0.73 | Dificultad media | 81-82 | 0.53 |

| 55-56 | 0.58 | ||

| 7-8 | 0.62 | ||

| 27-28 | 0.63 | ||

| 17-18 | 0.64 | ||

| 21-22 | 0.64 | ||

| 5-6 | 0.65 | ||

| 45-46 | 0.68 | ||

| 57-58 | 0.68 | ||

| 13-14 | 0.69 | ||

| 71-72 | 0.69 | ||

| 3-4 | 0.7 | ||

| 61-62 | 0.7 | ||

| 83-84 | 0.7 | ||

| 25-26 | 0.71 | ||

| 65-66 | 0.72 | ||

| 79-80 | 0.72 | ||

| 67-68 | 0.73 | ||

| 0.74 a 0.86 | Medianamente fáciles | 49-50 | 0.74 |

| 33-34 | 0.75 | ||

| 23-24 | 0.76 | ||

| 41-42 | 0.76 | ||

| 35-36 | 0.77 | ||

| 47-48 | 0.77 | ||

| 73-74 | 0.8 | ||

| 75-76 | 0.8 | ||

| 1-2 | 0.81 | ||

| 29-30 | 0.81 | ||

| 63-64 | 0.82 | ||

| 37-38 | 0.84 | ||

| 39-40 | 0.85 | ||

| 77-78 | 0.85 | ||

| 43-44 | 0.86 |

Discusión y conclusiones

Considerando el objetivo de esta investigación, validar un instrumento que permita evaluar de forma objetiva los conocimientos de la CDD de los futuros docentes de educación secundaria a partir de la adaptación de la herramienta COMDID-C en su versión para maestros, se puede afirmar que la herramienta de evaluación inicial de la CDD se ha realizado. Se ha contado con la participación de 11 universidades, 21 expertos y 667 futuros docentes de educación secundaria. Esta herramienta permite evaluar la CDD de los futuros docentes a partir de casos y no a partir de la autopercepción, tal como estudios previos sobre CDD sugerían como necesidad (Palau et al., 2019) o como Revuelta-Domínguez et al., (2022) mostraban.

Como señalan estudios anteriores (Pallisera et al., 2010; Lázaro et al., 2019) la evaluación de competencias es compleja y sería aconsejable el uso de diferentes técnicas y métodos. Por lo tanto, esta herramienta puede contribuir a ser una más de ellas y aportar la posibilidad de contrastar datos.

Aunque 667 es un número muestral a priori suficiente teniendo en cuenta que el cuestionario muestra 44 ítems de cuatro dimensiones (i.e. hay más de 10 observaciones por ítem), la herramienta muestra de forma aleatoria solamente una pregunta de cada par de ítems y este hecho hace que cada pregunta haya tenido la mitad de las respuestas de la muestra. Esto provoca que el análisis de las respuestas no se haya podido hacer con las mismas técnicas que su versión de COMDID-C para maestros. El principal efecto limitador de tal decisión se ha encontrado en los análisis de fiabilidad alterados, aunque en general se hace una valoración favorable de la aleatorización.

El hecho de calcular la consistencia interna del instrumento a partir de la aleatorización de Alchemer, donde cada participante ha respondido una de cada dos preguntas puede haber creado interferencias en el análisis. En el análisis de fiabilidad se han obtenido, según resultados del índice Alfa ordinal que los factores no tienen buena consistencia interna (valores inferiores a 0.4), por lo que se deben mejorar revisar y mejorar este aspecto. A partir del análisis y del sólido proceso de construcción y validación del instrumento descrito, las explicaciones más plausibles para justificar este aspecto son, primero, que el análisis se ha realizado a partir de pares de preguntas aleatorizadas. Al ser siempre aleatorias no se puede establecer ningún otro sistema de equivalencias para su análisis y los beneficios que aporta tal decisión han podido acaecer limitadores en el análisis final. Segundo, cada una de las cuatro dimensiones abarca subdimensiones y una gran cantidad de ítems, lo que podría afectar a la consistencia interna.

Por otro lado, la calidad es aceptable para la gran mayoría de ítems, y los que no alcanzan un nivel adecuado, pueden ser revisados en profundidad o ser descartados definitivamente. Relacionado con esto, la dimensión 3 de Aspectos relacionales, ética y seguridad obtiene menor consistencia y calidad, lo que sugiere que hay un componente de subjetividad que, nuevamente, la aleatorización y su consecuente emparejamiento de ítems equivalentes puede distorsionar de una forma más intensa que en las otras dimensiones, en las cuales tienen más peso aspectos más objetivos como el conocimiento o la habilidad.

En cualquier caso, y teniendo en cuenta la consistencia interna descrita mediante el análisis factorial confirmatorio, se puede constatar que el instrumento mantiene una estructura equiparable al instrumento predecesor, COMDID-C versión para maestros (Lázaro et al., 2019).

Respecto a la dificultad de los ítems, se considera suficientemente adecuada. Una buena parte de los reactivos están clasificados dentro de una dificultad media y hay una tendencia a que sean ligeramente más fáciles. Un pequeño número son altamente fáciles o difíciles, por lo que se debe valorar una modificación del enunciado y/o de los distractores.

En relación con las limitaciones del estudio, la primera radica en que el muestreo fue por conveniencia, lo que conlleva una escasa representatividad. La segunda, la elección de la aleatorización de Alchemer implica obtener unos resultados que pueden variar respecto de otra técnica. Para investigaciones futuras, se sugiere escoger otro método de aleatorización, así como obtener una muestra mayor y más diversa. A partir de la validación del presente instrumento, se pretende valorar la CDD con diferentes perfiles y contextos.

Por último, las implicaciones de este estudio pueden considerarse en diversos niveles y ámbitos de toma de decisiones. A nivel de los futuros docentes de secundaria les permite conocer en qué situación están con respecto a la CDD y esto les permite establecer su plan de mejora y adquisición de esta a partir de la reflexión. Con relación a las direcciones y coordinaciones de los Másteres de Formación de Profesorado en Educación Secundaria, tener una herramienta que permite reflexionar sobre el nivel tanto de partida o salida, según se administre como pretest o postest y, a partir de estos datos, diseñar y adecuar los planes de formación para una mejor adquisición de esta competencia por parte de los estudiantes del máster. A nivel de las administraciones educativas podrían, por un lado, utilizar la herramienta para evaluar las necesidades de formación futura de los docentes noveles y, al mismo tiempo, colaborar con las universidades formadoras de estos para establecer mecanismos de coordinación y colaboración para una mejor adecuación a las necesidades del mercado educativo.

Agradecimientos

Este artículo es resultado del proyecto "CERTICDOCENT: Certificació de la Competència Digital Docent del professorat d’educació secundària en formació inicial", Ajuts de recerca per a la millora de la formació inicial de mestres i professorat de secundària, AGAUR. Coord.: Ramon Palau, Universitat Rovira i Virgili. Número de referencia: 2020 ARMIF 00006.

Referencias

Andía-Celaya, L.A., Santiago-Campión, R., & Sota-Eguizábal, J. M. (2020). ¿Estamos técnicamente preparados para el flipped classroom? un análisis de las competencias digitales de los profesores en España. Contextos Educativos, 25, 275-311. http://doi.org/10.18172/con.4218

Backhoff, E., Larrazolo, N., & Rosas, M. (2000). Nivel de dificultad y poder de discriminación del Examen de Habilidades y Conocimientos Básicos (EXHCOBA). REDIE. Revista Electrónica de Investigación Educativa, 2(1). https://www.redalyc.org/articulo.oa?id=15502102

Banister, S., & Reinhart, R. (2012). Assessing NETS-T performance in teacher candidates: Exploring the Wayfind teacher assessment. Journal of Digital Learning in Teacher Education, 29(2), 59-65. https://doi.org/10.1080/21532974.2012.10784705

Cai, Z., Fan, X., & Du, J. (2017). Gender and attitudes toward technology use: A meta-analysis. Computers & Education, 105, 1-13. https://doi.org/10.1016/j.compedu.2016.11.003

Castañeda, L., Esteve, F., & Adell, J. (2018). ¿Por qué es necesario repensar la competencia docente para el mundo digital? Revista de Educación a Distancia, 56, 1–20. https://doi.org/10.6018/red/56/6

Comisión Europea. (2018a). DigCompOrg: Digitally Competent Educational Organisations.https://bit.ly/2AM8gQH

Comisión Europea. (2018b). SELFIE (Self-Reflection on Effective Learning by Fostering the Use of Innovative Educational Technologies). https://education.ec.europa.eu/selfie/about-selfie

Comisión Europea. (2021). Plan de Acción de Educación Digital (2021-2027).https://education.ec.europa.eu/es/plan-de-accion-de-educacion-digital-2021-2027

Cosi, A., Voltas, N., Lázaro, J. L., Morales,P., Calvo, M., Molina, S., & Quiroga, M. A. (2020). Formative assessment at university through digital technology tools. Profesorado, Revista De Currículum Y Formación Del Profesorado, 24(1), 164-183. https://doi.org/10.30827/profesorado.v24i1.9314

Domínguez-Lara, S. (2018). Fiabilidad y alfa ordinal. Actas Urológicas Españolas, 42(2), 140-141. https://doi.org/10.1016/j.acuro.2017.07.002

Elosua P, & Zumbo B. (2008). Coeficientes de fiabilidad para escalas de respuesta categórica ordenada. Psicothema, 20(5), 896–901.

Enlaces. (2008). Estándares TIC para la Formación Inicial Docente: Una propuesta en el contexto Chileno. Ministerio de Educación, Gobierno de Chile.

Enlaces. (2011). Competencias y estándares TIC para la profesión docente. Ministerio de Educación, Gobierno de Chile.

Fan, X., & Sivo, S. A. (2007). Sensitivity of fit indices to model misspecification and model types. Multivariate Behavioral Research, 42, 509–529. http://doi.org/10.1080/00273170701382864

Ferrari, A. (2013). DIGCOMP: A Framework for Developing and Understanding Digital Competence in Europe. JRC-IPTS.

Fraser, J., Atkins, L., & Richard, H. (2013). DigiLit leicester. Supporting teachers, promoting digital literacy, transforming learning. Leicester City Council.

Generalitat de Catalunya (2018). Competència digital docent del professorat de Catalunya. Departament d’Ensenyament. https://bit.ly/37AJH5f

Hooper, D., Coughlan, J., & Mullen, M. R. (2008). Structural equation modelling: Guidelines for determining model fit. Electronic Journal of Business Research Methods, 6, 53–60.

Ilomäki, L., Paavola, S., Lakkala, M., & Kantosalo, A. (2016). Digital competence – an emergent boundary concept for policy and educational research. Education and Information Technologies, 21, 655–679. https://doi.org/10.1007/s10639-014-9346-4

INTEF. (2014). Marco Común de Competencia Digital Docente. Instituto Nacional de Tecnologías Educativas y de Formación del Profesorado.http://educalab.es/documents/10180/12809/MarcoComunCompeDigiDoceV2.pdf/e8766a69-d9ba-43f2-afe9-f526f0b34859

INTEF. (2017). Marco Común de Competencia Digital Docente.http://educalab.es/documents/10180/12809/MarcoComunCompeDigiDoceV2.pdf

INTEF. (2022). Marco de referencia de la Competencia Digital Docente.https://intef.es/wp-content/uploads/2022/03/MRCDD_V06B_GTTA.pdf

ISTE. (2008). National educational technology standards for teachers. Washington DC: International Society for Technology in Education.

Jiménez-Hernández, D., González-Calatayud, V., Torres-Soto, A., Martínez Mayoral, A., & Morales, J. (2020). Digital Competence of Future Secondary School Teachers: Differences According to Gender, Age, and Branch of Knowledge. Sustainability, 12(22), 9473. https://doi.org/10.3390/su12229473

Krumsvik, R. J. (2008). Situated learning and teachers’ digital competence. Education and Information Technologies, 13(4), 279–290. https://doi.org/10.1007/s10639-008-9069-5

Krumsvik, R. J. (2014). Teacher educators' digital competence. Scandinavian Journal of Educational Research, 58(3), 269-280. https://doi.org/10.1080/00313831.2012.726273

Lázaro, J. L., & Gisbert, M. (2015). Elaboración de una rúbrica para evaluar la competencia digital del docente. UTE. Revista de Ciències de l’Educació, 1, 30–47. https://doi.org/10.17345/ute.2015.1.648

Lázaro, J. L., Usart, M., & Gisbert, M. (2019). Assessing Teacher Digital Competence: the Construction of an Instrument for Measuring the Knowledge of Pre-Service Teachers. Journal of New Approaches in Educational Research, 8(1), 73-78. https://doi.org/10.7821/naer.2019.1.370

Lucas, M., Bem-Haja, P., Siddiq, F., Moreira, A., & Redecker, C. (2021). The relation between in-service teachers' digital competence and personal and contextual factors: What matters most? Computers & Education (160), 104052. https://doi.org/10.1016/j.compedu.2020.104052

Mahias Finger, P., & Polloni Erazo, M. P. (2019). Cuadernillo técnico de evaluación educativa Desarrollo de instrumentos de evaluación: pruebas. Centro de Medición MIDE UC. Instituto Nacional para la Evaluación de la Educación. https://www.inee.edu.mx/wp-content/uploads/2019/08/P2A354.pdf

McDonald, R. P., y Ho, M. (2002). Principles and practice in reporting structural equation analysis. Psychological Methods, 7, 64–82. https://doi.org/10.1037/1082-989x.7.1.64

OECD. (2022). Trends Shaping Education 2022. OECD Publishing, Paris. https://doi.org/10.1787/6ae8771a-en

ONU. (2015).Agenda for Sustainable Development. Resolution Adopted by the General Assembly on 25 September 2015 (A/70/L.1). http://sustainabledevelopment.un.org/post2015/transformingourworld

Palau, R., & Mogas, J. (Eds.). (2022a). La competència digital docent al màster de formació del professorat de les universitats de Catalunya. Octaedro. https://doi.org/10.36006/82001-1

Palau, R., & Mogas, J. (Eds.). (2022b). Activitatsper al desenvolupament de la competència digital docent al màster de formació del professorat. Octaedro. https://doi.org/10.36006/82002-1

Palau, R., Fuentes, M., Mogas, J., & Cebrián, G. (2021). Analysis of the implementation of teaching and learning processes at Catalan schools during the Covid-19 lockdown. Technology, Pedagogy and Education, 30(1), 183-199. https://doi.org/10.1080/1475939X.2020.1863855

Palau, R., Usart, M., & Ucar, M. J. (2019). La competencia digital de los docentes de los conservatorios. Estudio de autopercepción en España. Revista Electrónica de LEEME (44). https://doi.org/10.7203/LEEME.44.15709

Pallisera, M., Fullana Noell, J., Planas Lladó, A., & Valle Gómez, A. D. (2010). La adaptación al Espacio Europeo de Educación Superior en España: los cambios/retos que implica la enseñanza basada en competencias y orientaciones para responder a ellos. Revista Iberoamericana de Educación, 52(4), 1-13. http://hdl.handle.net/10256/3547

Pérez-Navío, E., Ocaña-Moral, M. T., & Martínez-Serrano, M. del C. (2021). University Graduate Students and Digital Competence: Are Future Secondary School Teachers Digitally Competent? Sustainability, 13(15), 8519. https://doi.org/10.3390/su13158519

Portillo, J., Garay, U., Tejada, E., & Bilbao, N. (2020). Self-Perception of the Digital Competence of Educators during the COVID-19 Pandemic: A Cross-Analysis of Different Educational Stages. Sustainability, 12(23), 10128. https://doi.org/10.3390/su122310128

Prieto-Ballester, J.-M., Revuelta-Domínguez, F.-I., & Pedrera-Rodríguez, M.-I. (2021). Secondary School Teachers Self-Perception of Digital Teaching Competence in Spain Following COVID-19 Confinement. Education Sciences, 11(8), 407. https://doi.org/10.3390/educsci11080407

Redecker, C. & Punie, Y. (2017). European Framework for the Digital Competence of Educators: DigCompEdu. Publications Office of the European Union.

Revuelta-Domínguez, F.-I., Guerra-Antequera, J., González-Pérez, A., Pedrera-Rodríguez, M.-I., & González-Fernández, A. (2022). Digital Teaching Competence: A Systematic Review. Sustainability, 14(11), 6428. https://doi.org/10.3390/su14116428

Sangrà, A. (2020). Tiempo de transformación educativa. Revista Innovaciones Educativas, 22, 22-27. http://dx.doi.org/10.22458/ie.v22iespecial.3249

Schleicher, A. (2022). Building on COVID-19's Innovation Momentum for Digital, Inclusive Education, International Summit on the Teaching Profession. OECD Publishing, Paris. https://doi.org/10.1787/24202496-en

Starkey, L. (2020). A review of research exploring teacher preparation for the digital age. Cambridge Journal of Education, 50(1), 37-56. https://doi-org/10.1080/0305764X.2019.1625867

Tejada, J., & Ruiz, C. (2016). Evaluación de competencias profesionales en Educación Superior: retos e implicaciones. Educación XX1, 19(1) 17-38. https://doi.org/10.5944/educXX1.12175

Tourón, J., Martín, D., Navarro, E., Pradas, S., & Iñigo, V. (2018). Construct validation of a questionnaire to measure teachers’ digital competence (TDC). Revista Española de Pedagogía, 76(269), 25-54. https://doi.org/10.22550/REP76-1-2018-02

UNESCO. (2008). Estándares de competencia en TIC para docentes. http://www.eduteka.org/EstandaresDocentesUNESCO.php

UNESCO. (2019). Marco de competencias de los docentes en materia de TIC.https://bit.ly/3bkUp0u

Viberg, O., Mavroudi, A., Khalil, M., & Bälter, O. (2020). Validating an instrument to measure teachers’ preparedness to use digital technology in their teaching. Nordic Journal of Digital Literacy, 15(1), 38-54. https://doi.org/10.18261/issn.1891-943x-2020-01-04

Notas de autor

jordi.mogas@urv.cat

Enlace alternativo

https://revistaseug.ugr.es/index.php/RELIEVE/article/view/25317 (html)